第3次作业:卷积神经网络

part1

首先是介绍了提纲,了解了视频基本内容

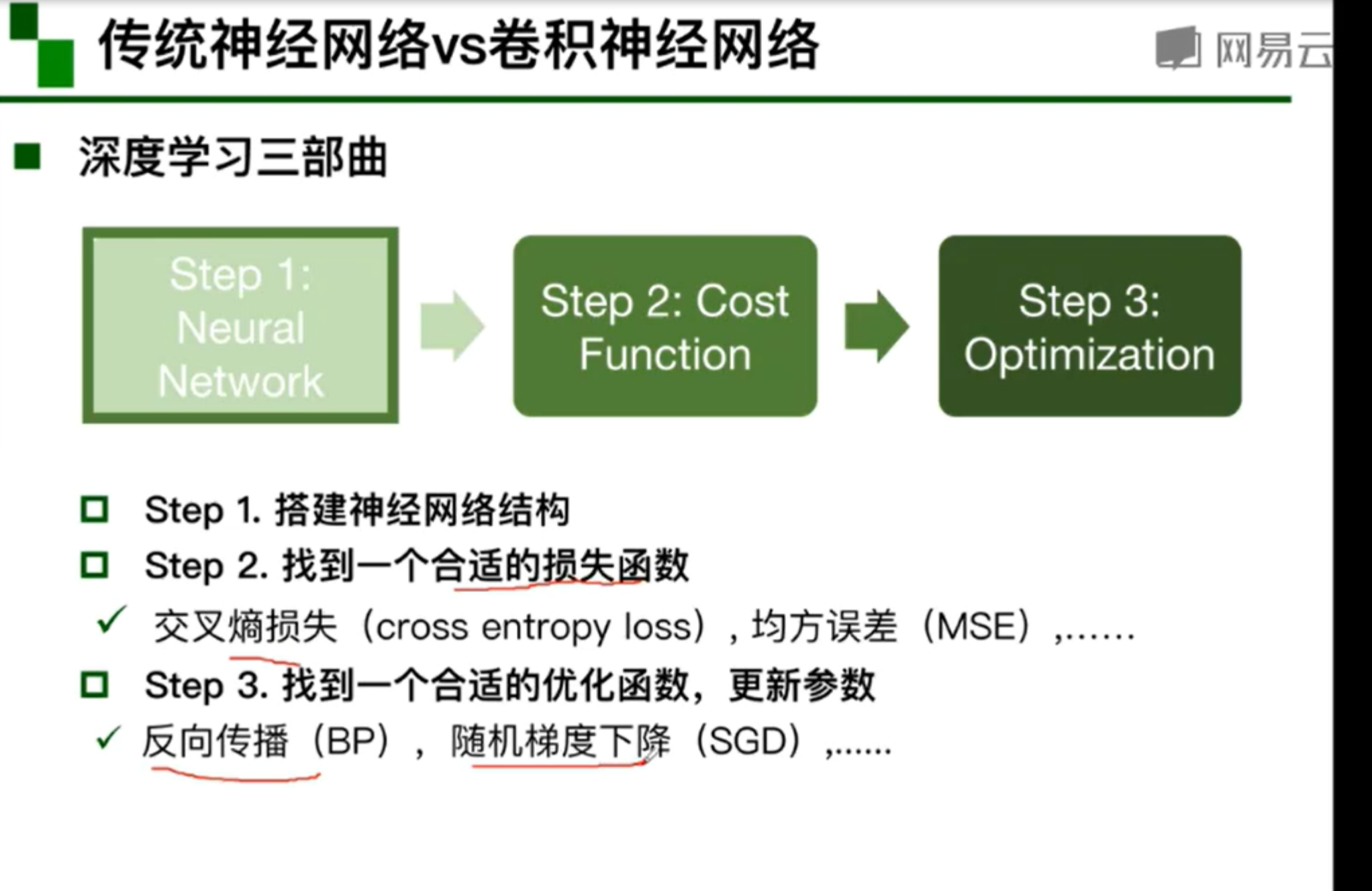

随后是对深度学习的步骤进行了概括性的说明

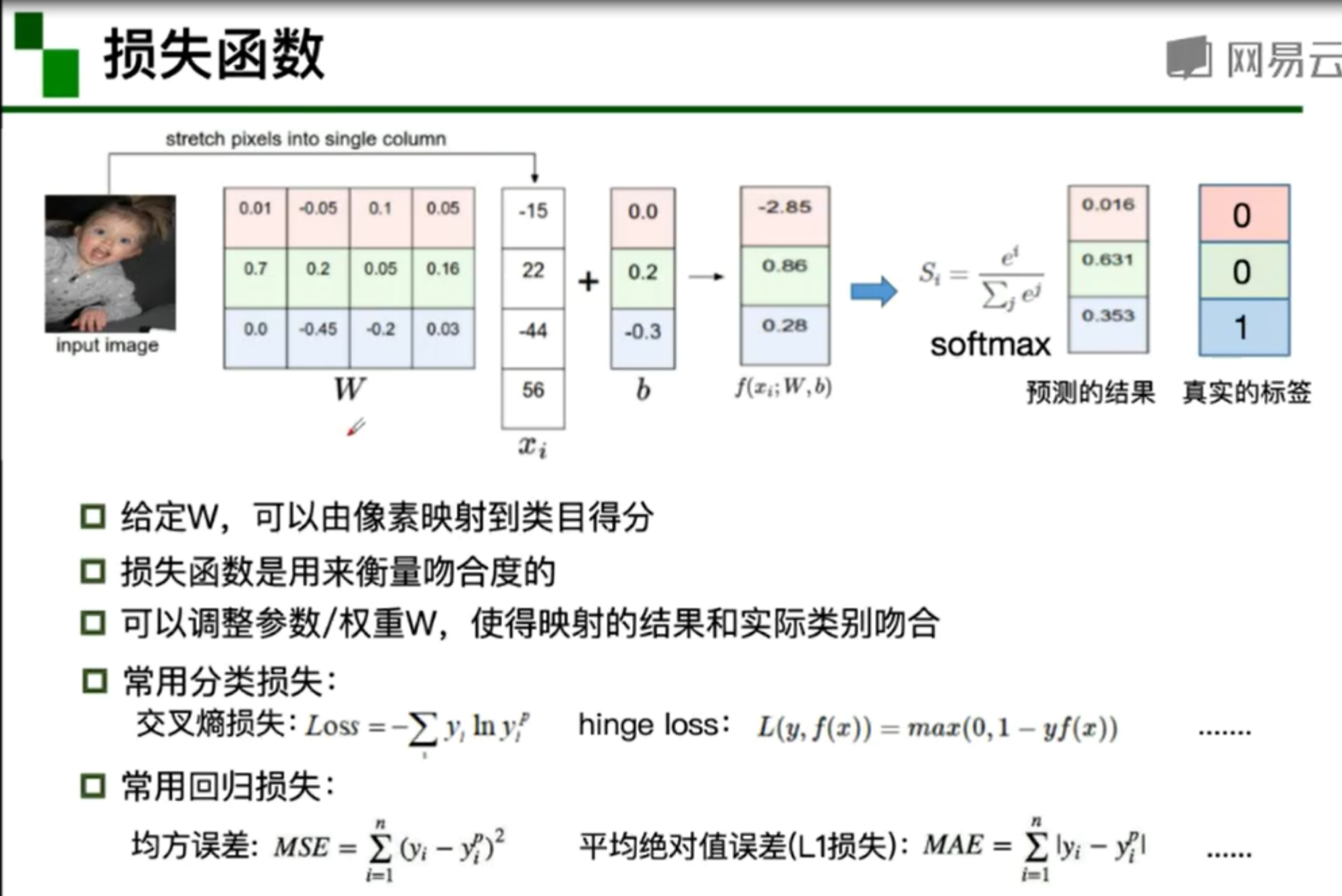

这里介绍了损失函数的定义以及常用的公式,主要用于衡量吻合度(偏差)

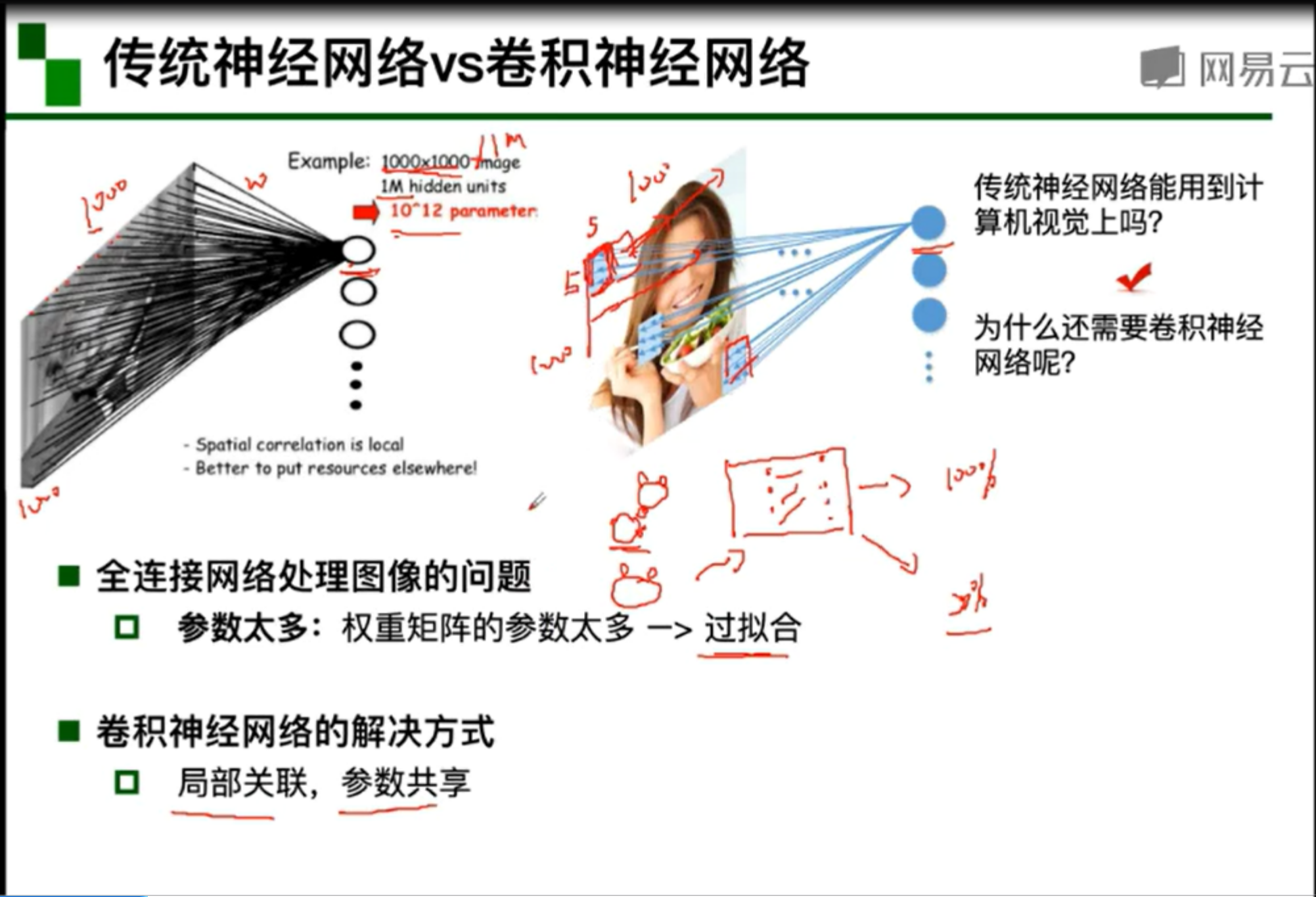

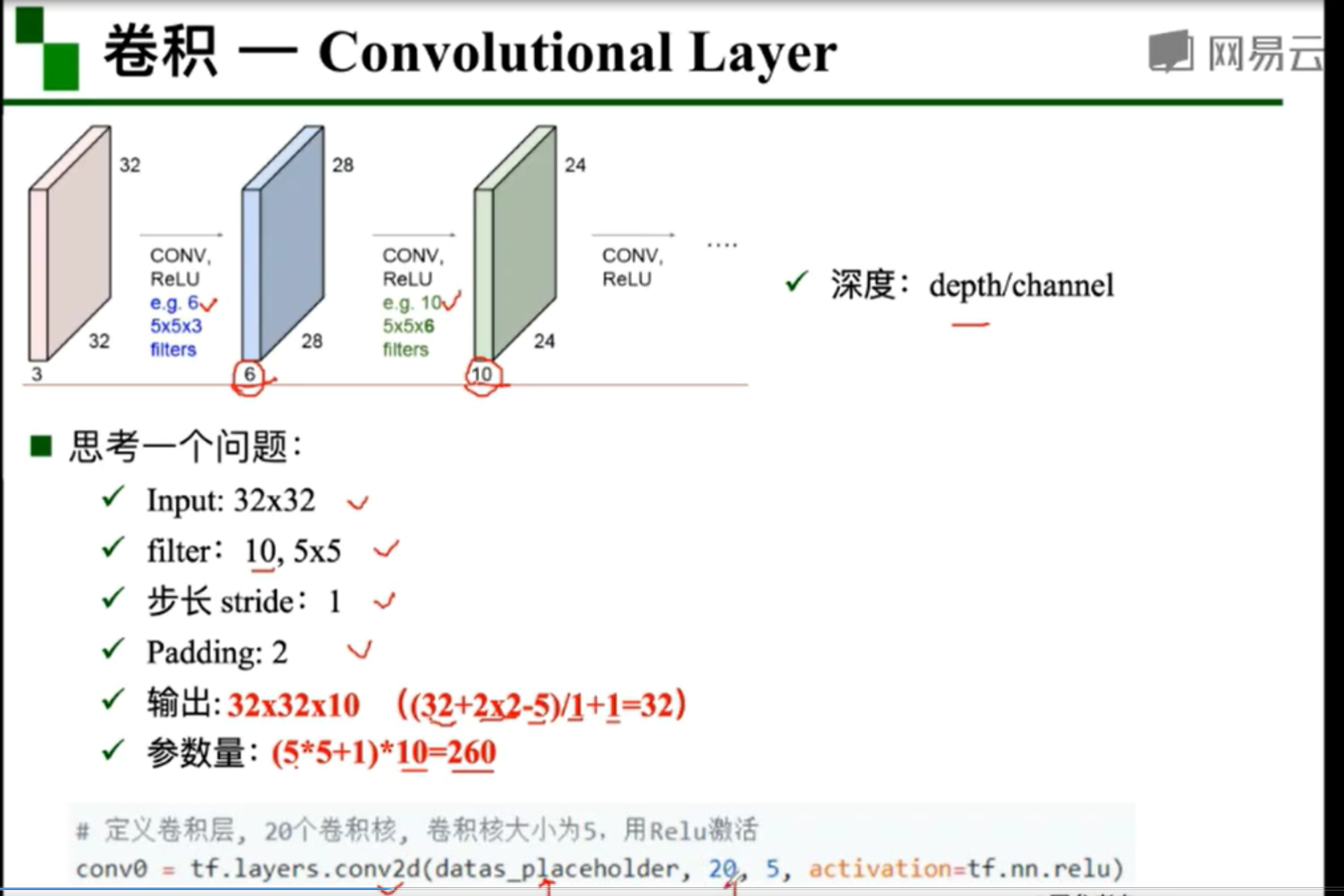

这里介绍了为什么全连接网络处理在图像处理准确度不高的原因:参数过多,考虑的因素太多导致过拟合(即抓不住主要的内容,被细枝末节的信息干扰)。而卷积神经网络将图像分割成块状(局部关联)且进行了参数共享,降低了复杂度与信息熵,抓住了主要的内容,提高了准确度。

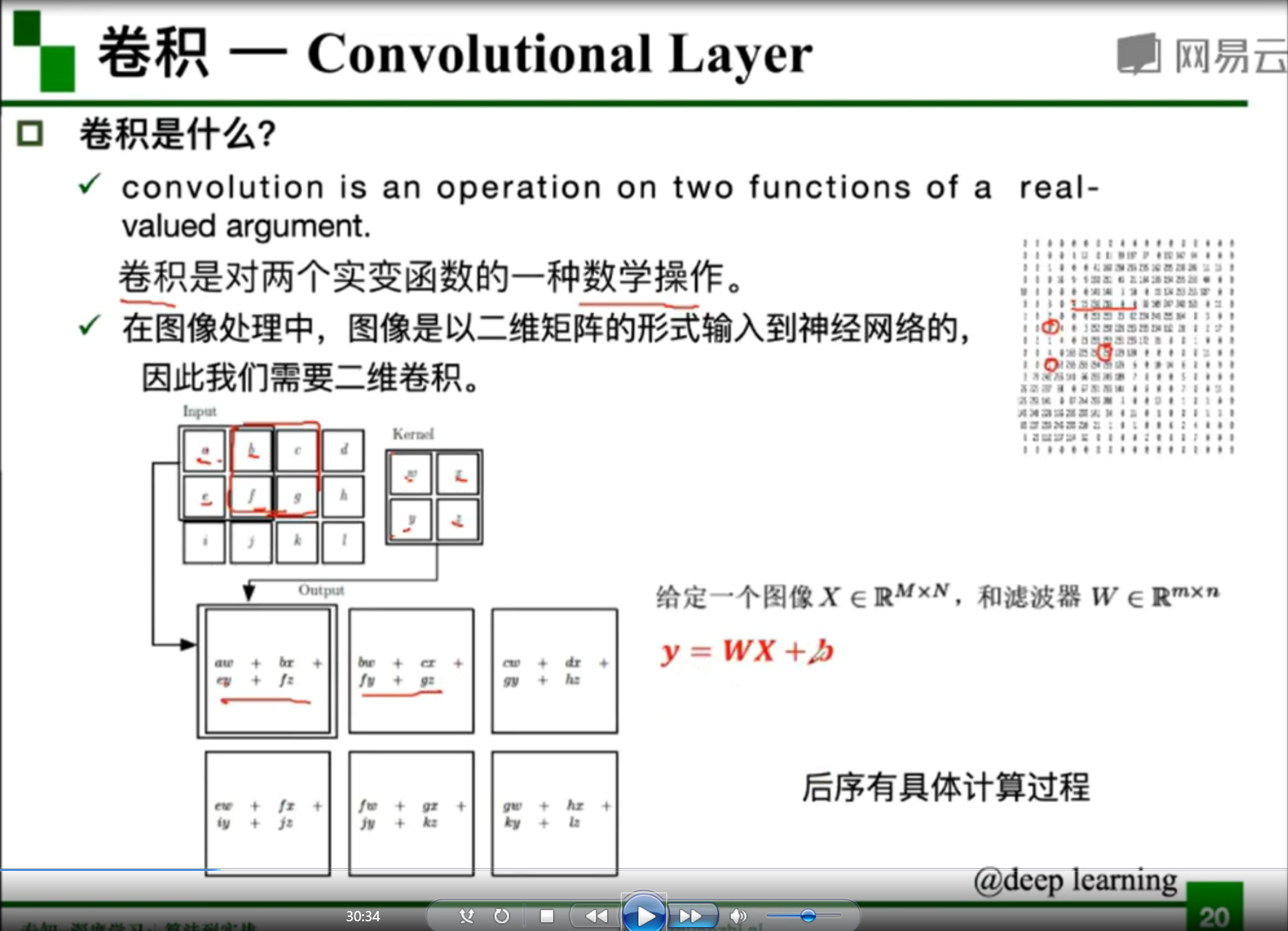

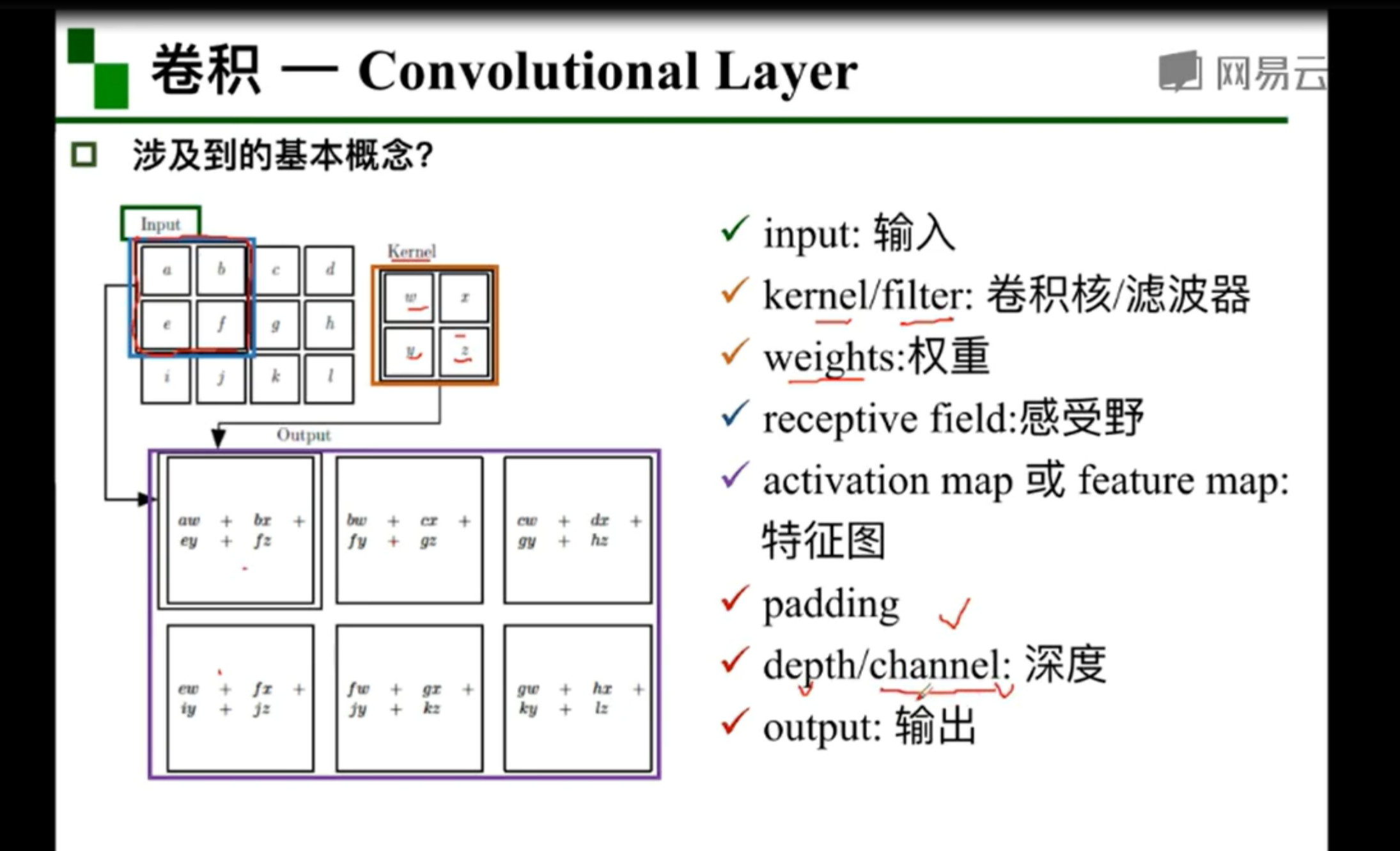

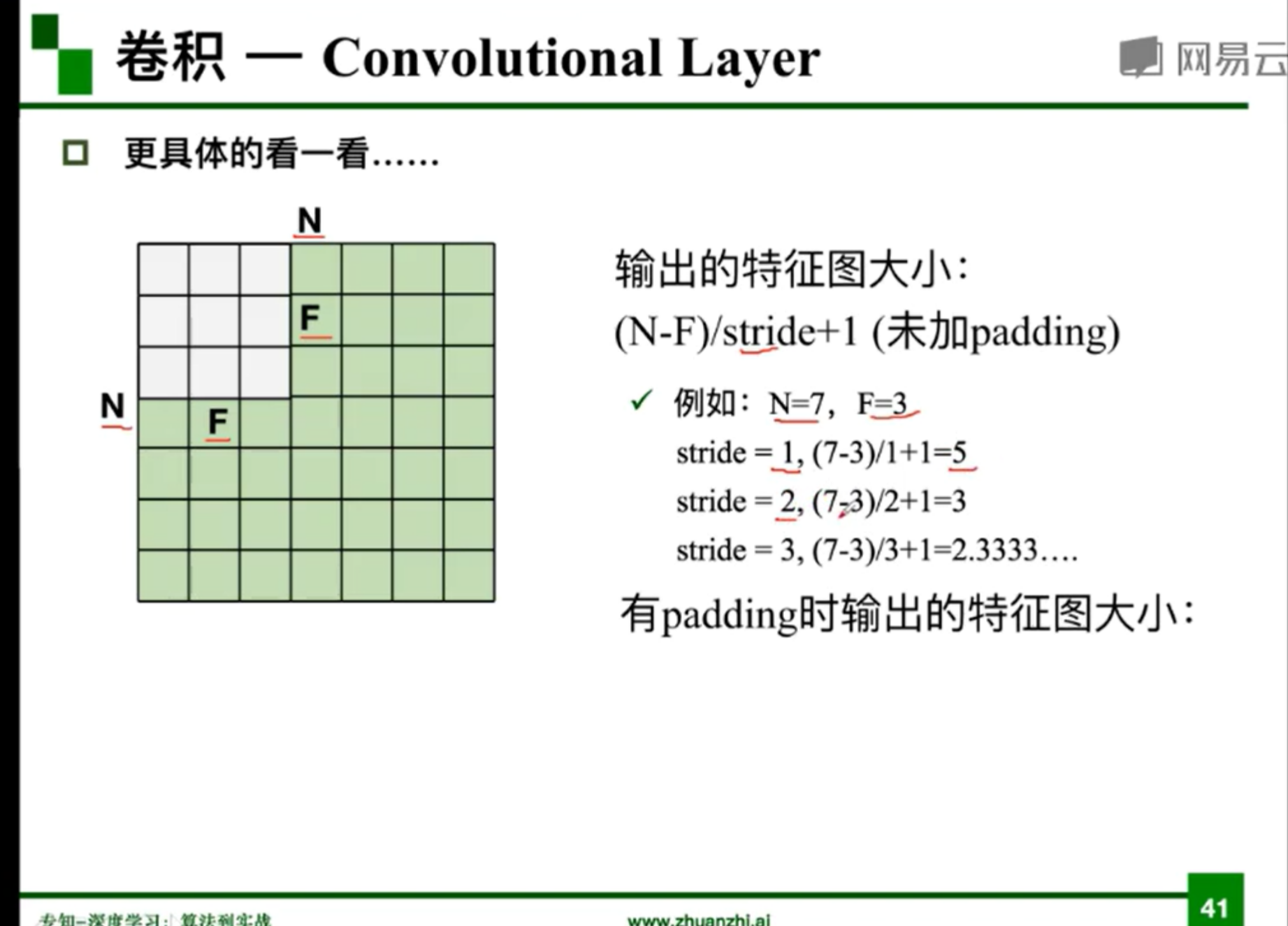

而后了解到了卷积的定义以及卷积的计算方式。

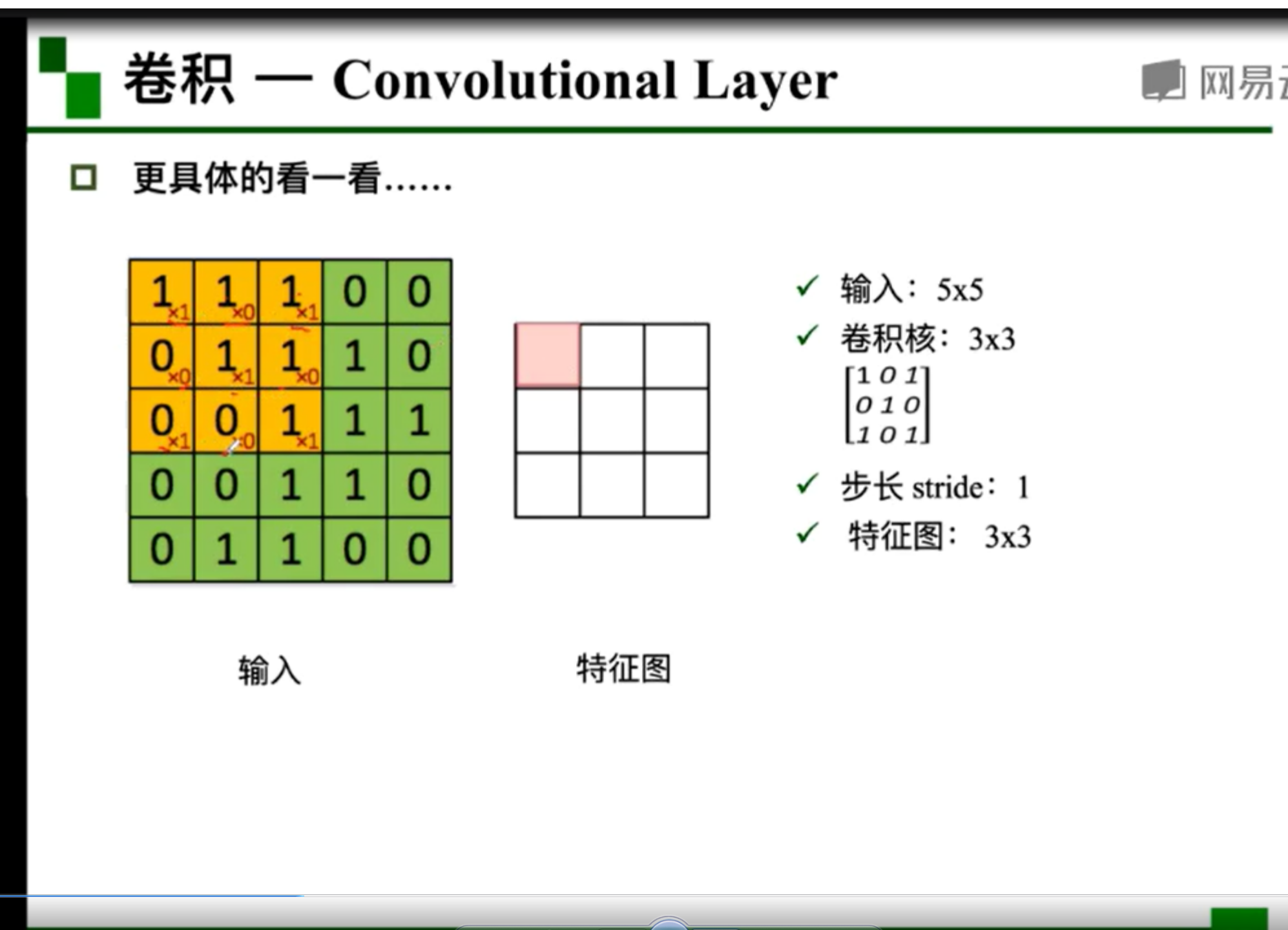

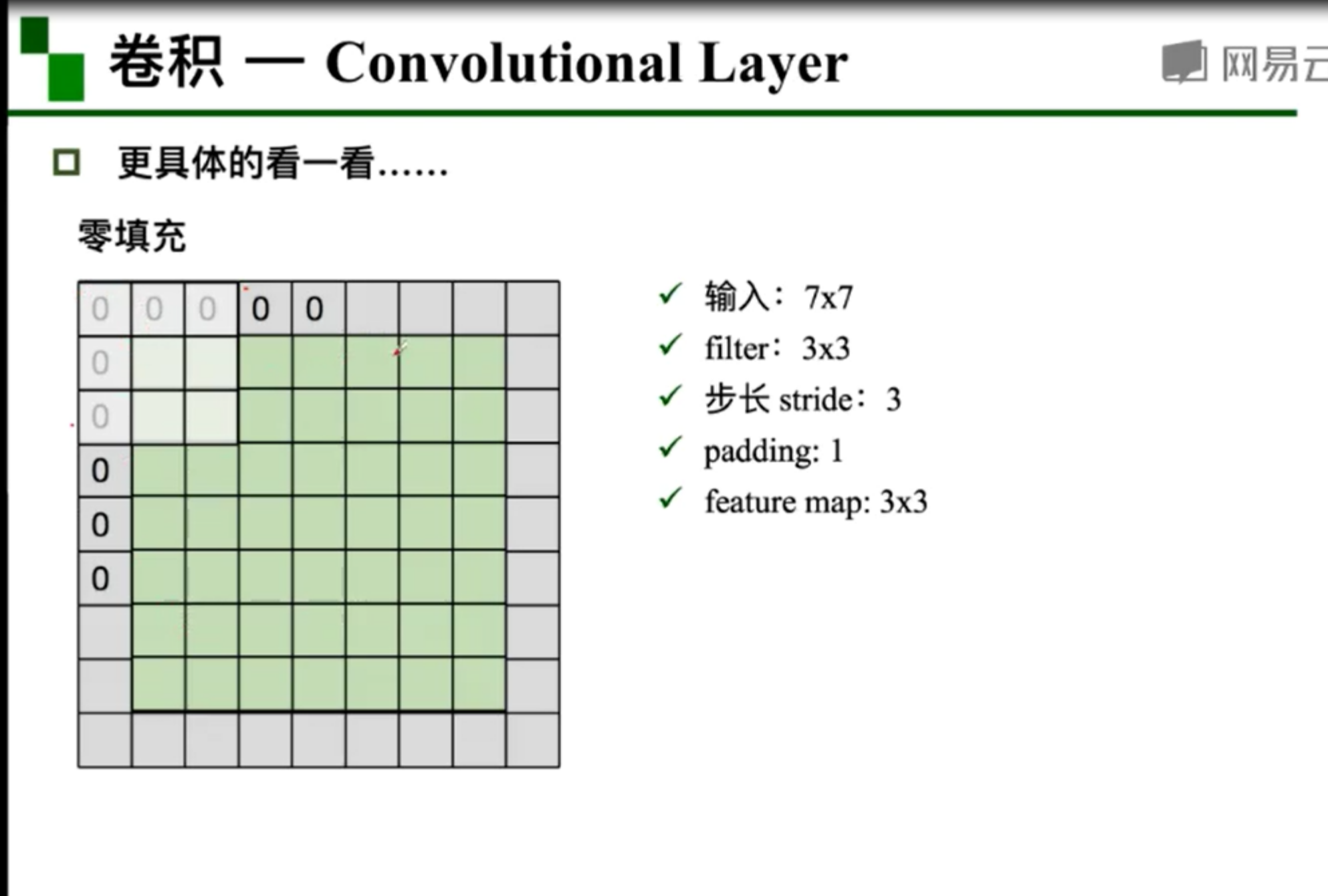

即对应位置相乘再相加为一格 通过平移形成了特征图(走到右下角)

验证。

所谓步长就是指平移的单位格个数。

关于这个计算我有一个问题:输出在前面所讲为输出时的概率 而这里却是一个具体的数。

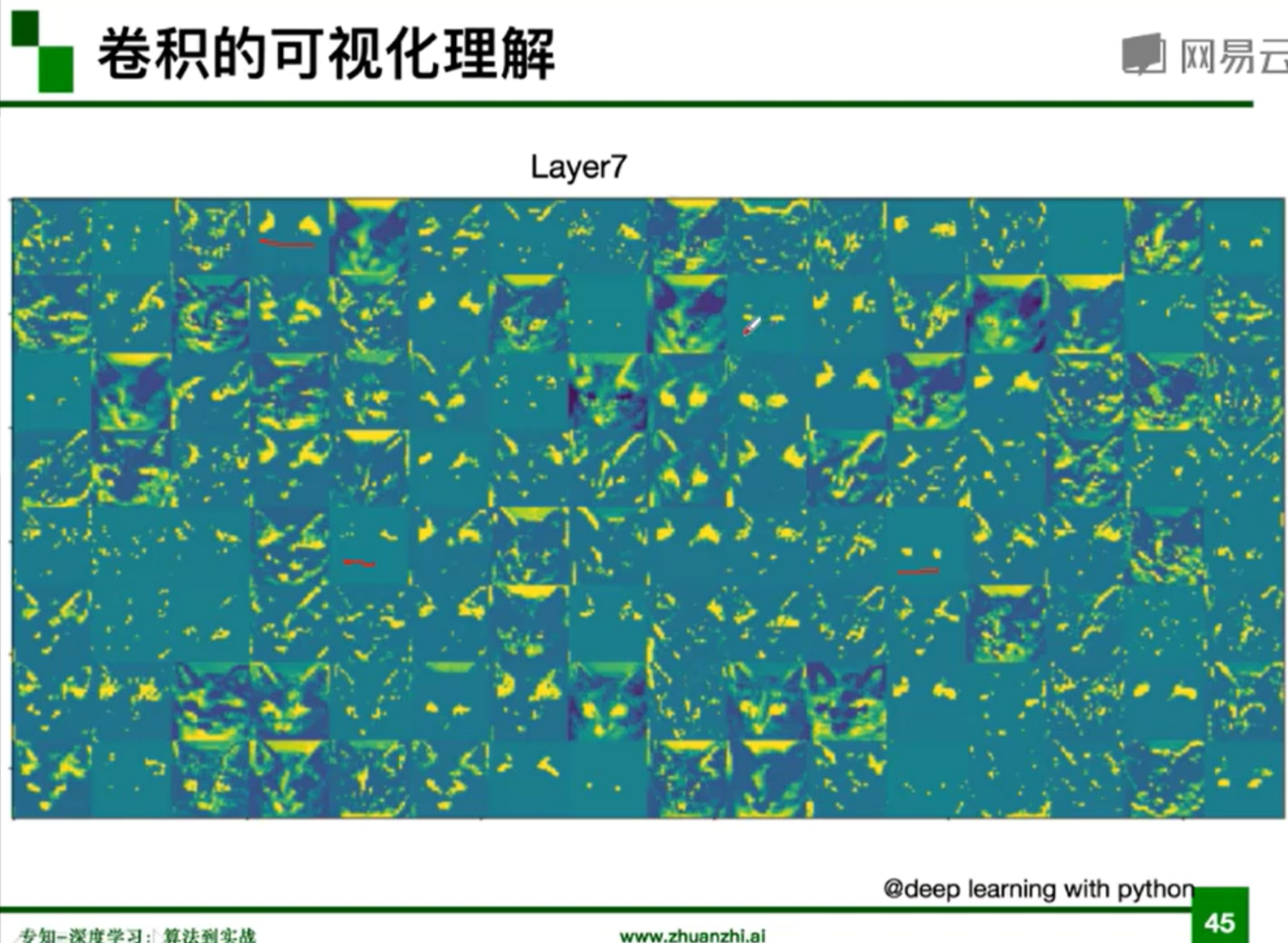

处理深度学习,如果不好看每一层学习的内容可以将其可视化查看。

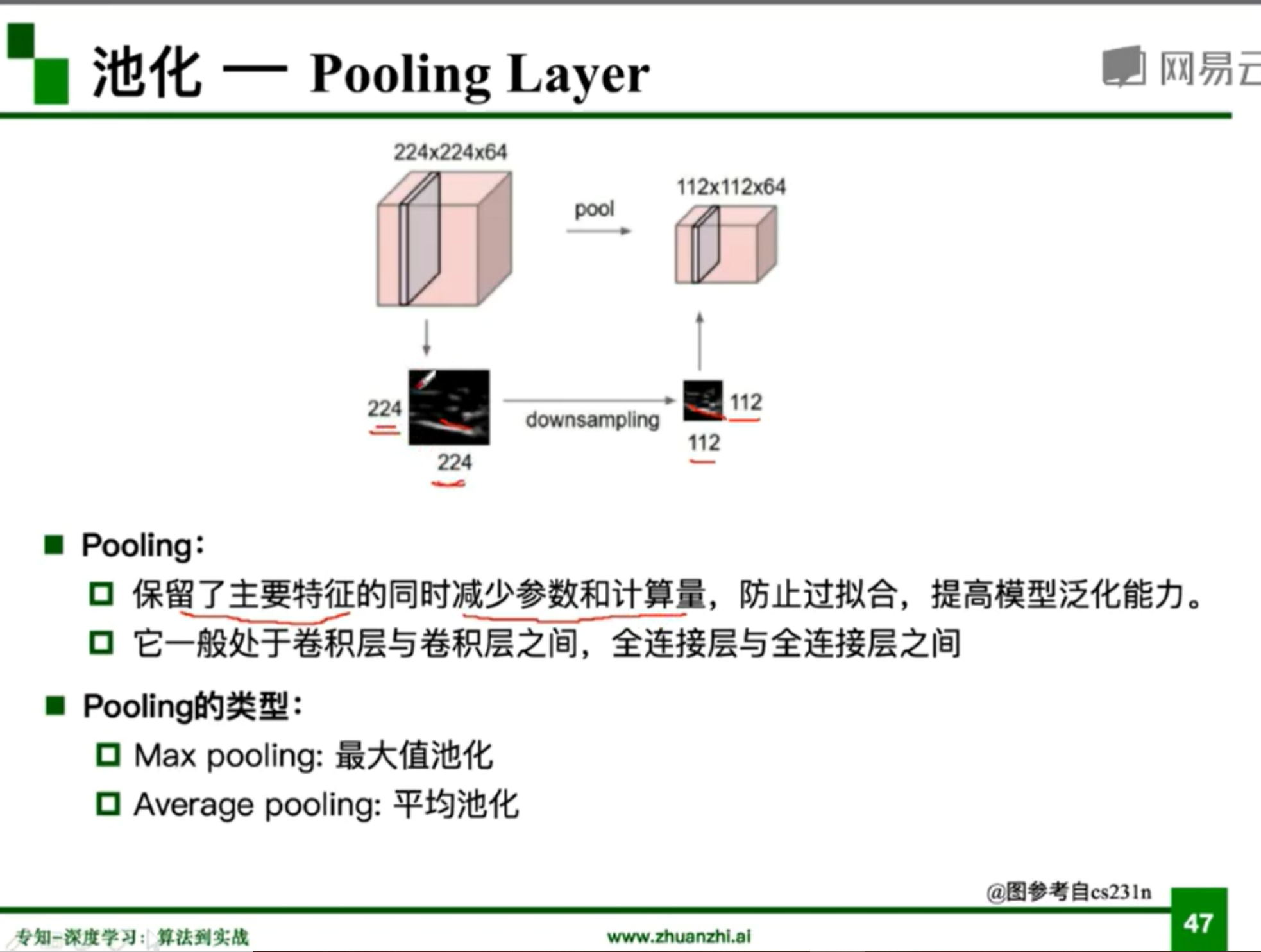

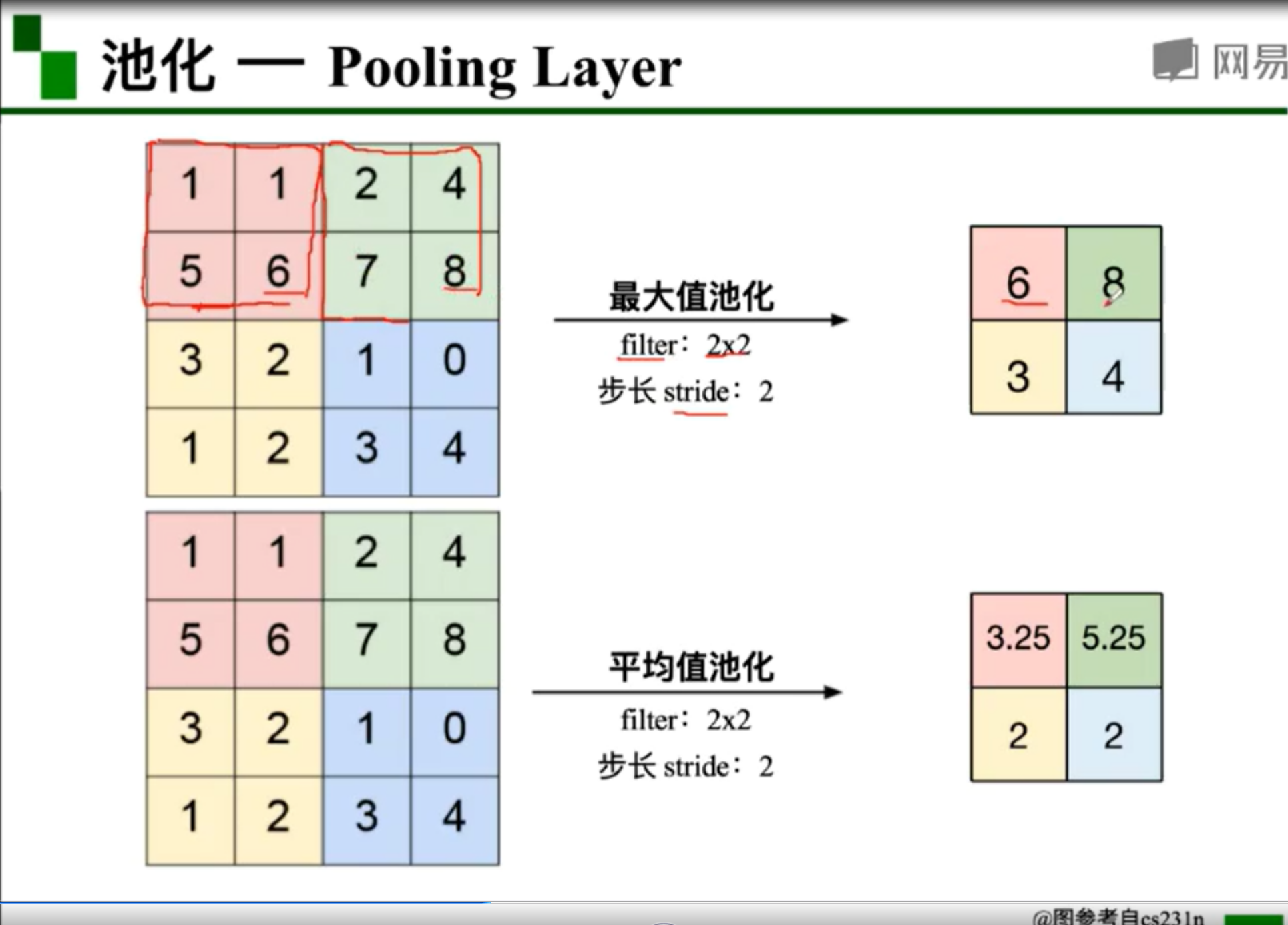

指在尽量少量损失信息的同时对图片进行缩放。优点如图所示

最大和平均。

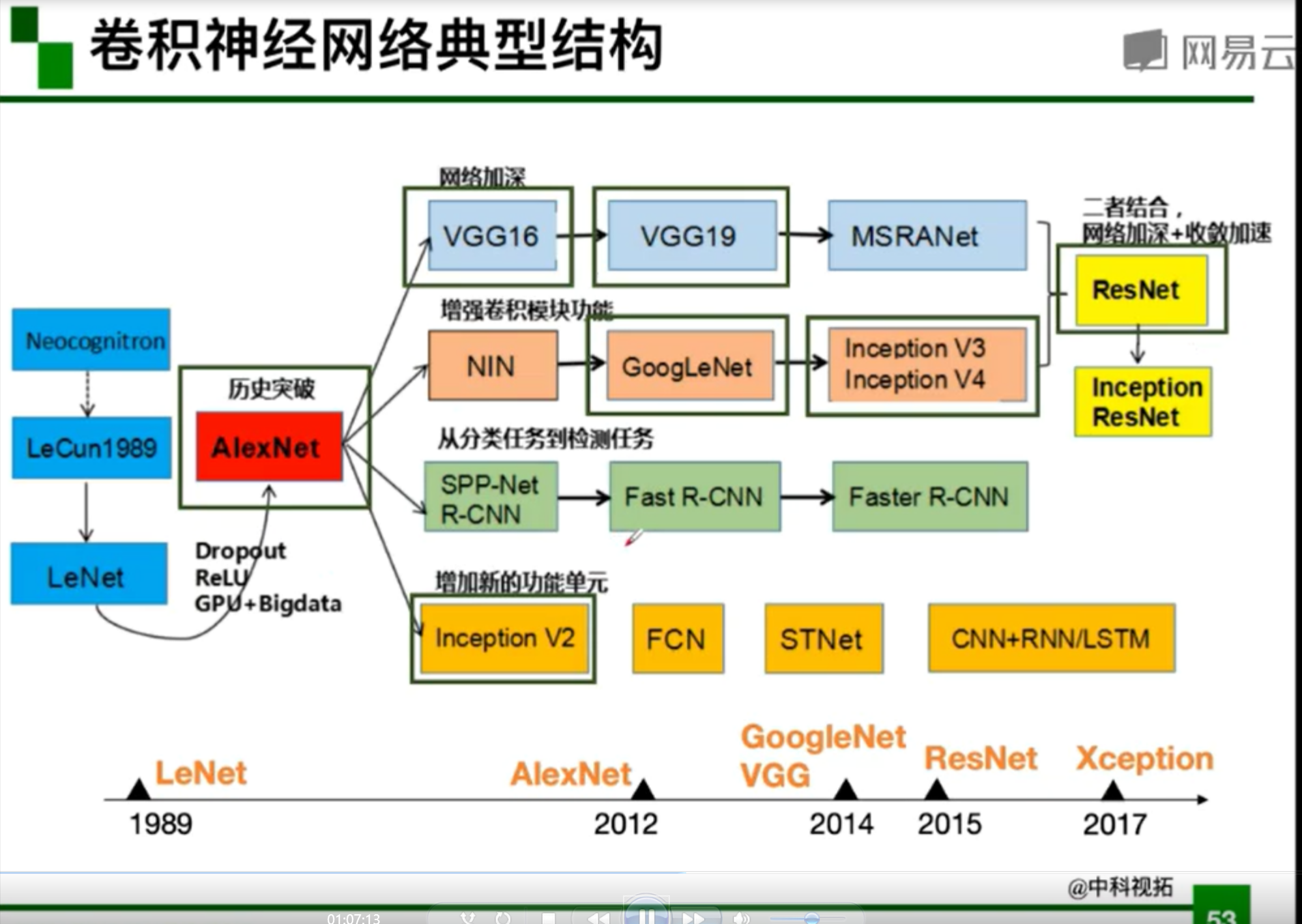

简介了历史

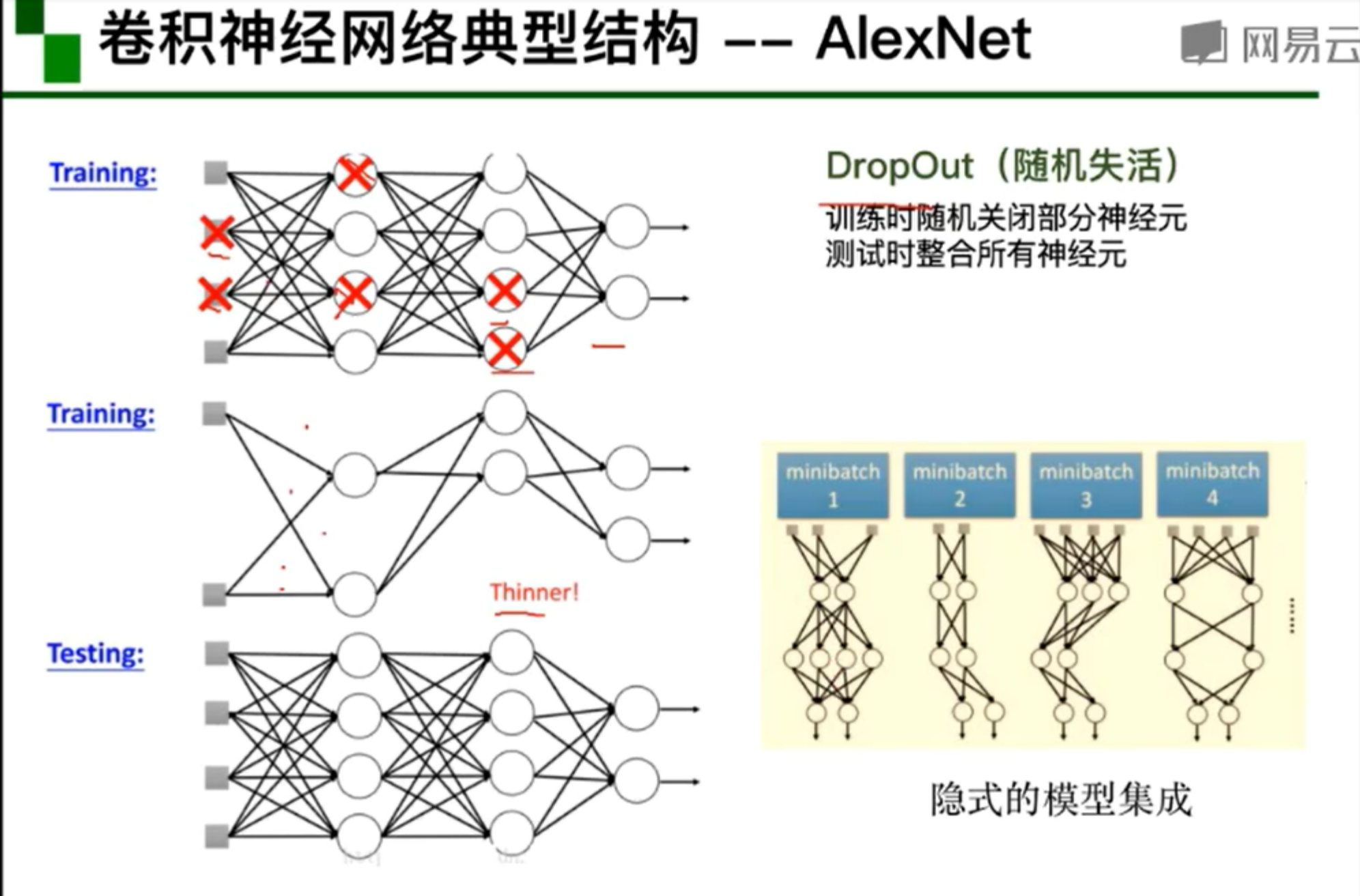

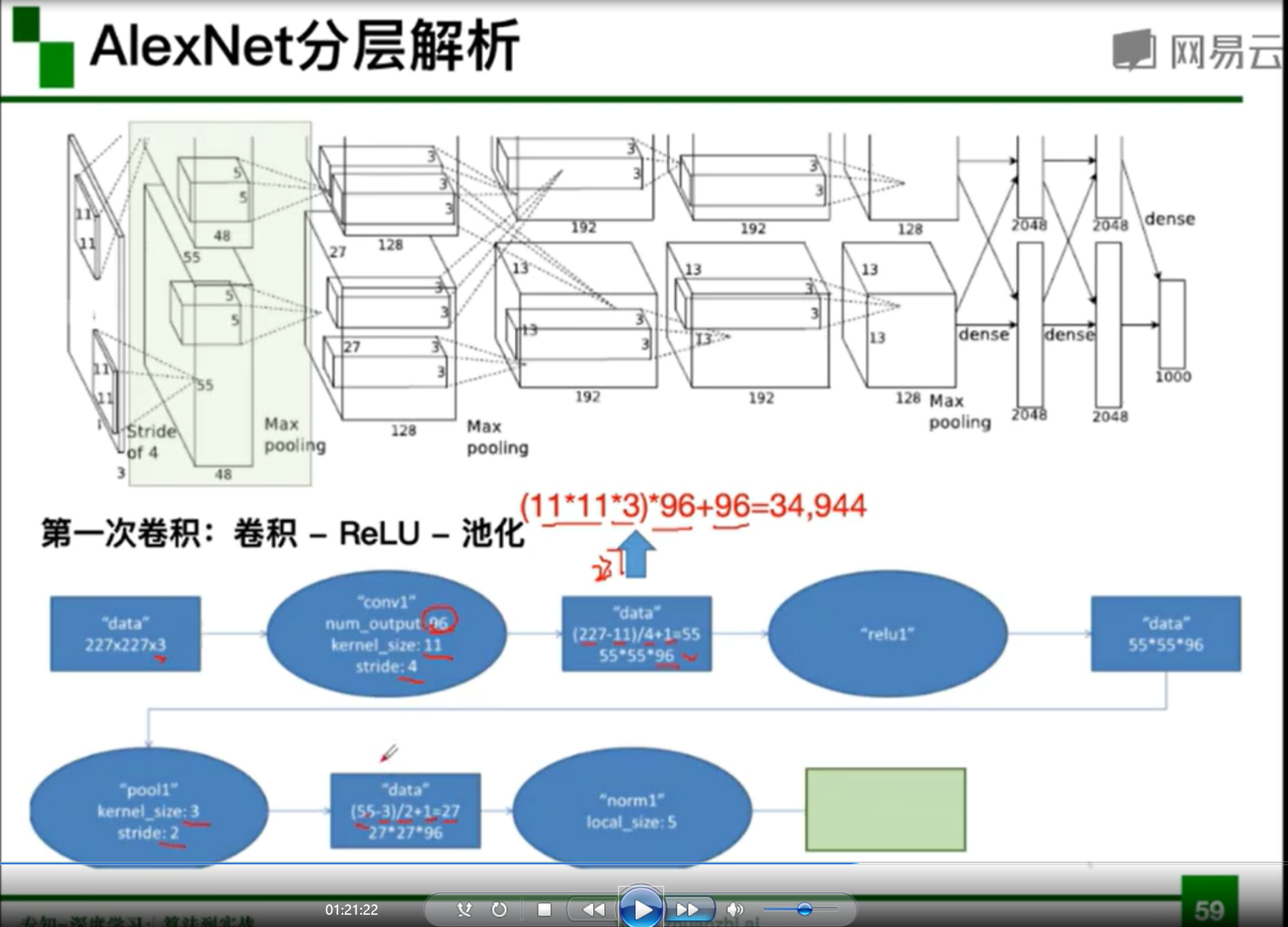

卷积-ReLU-池化 介绍了data和参数的计算(卷积)池化只是缩放不存在参数计算。

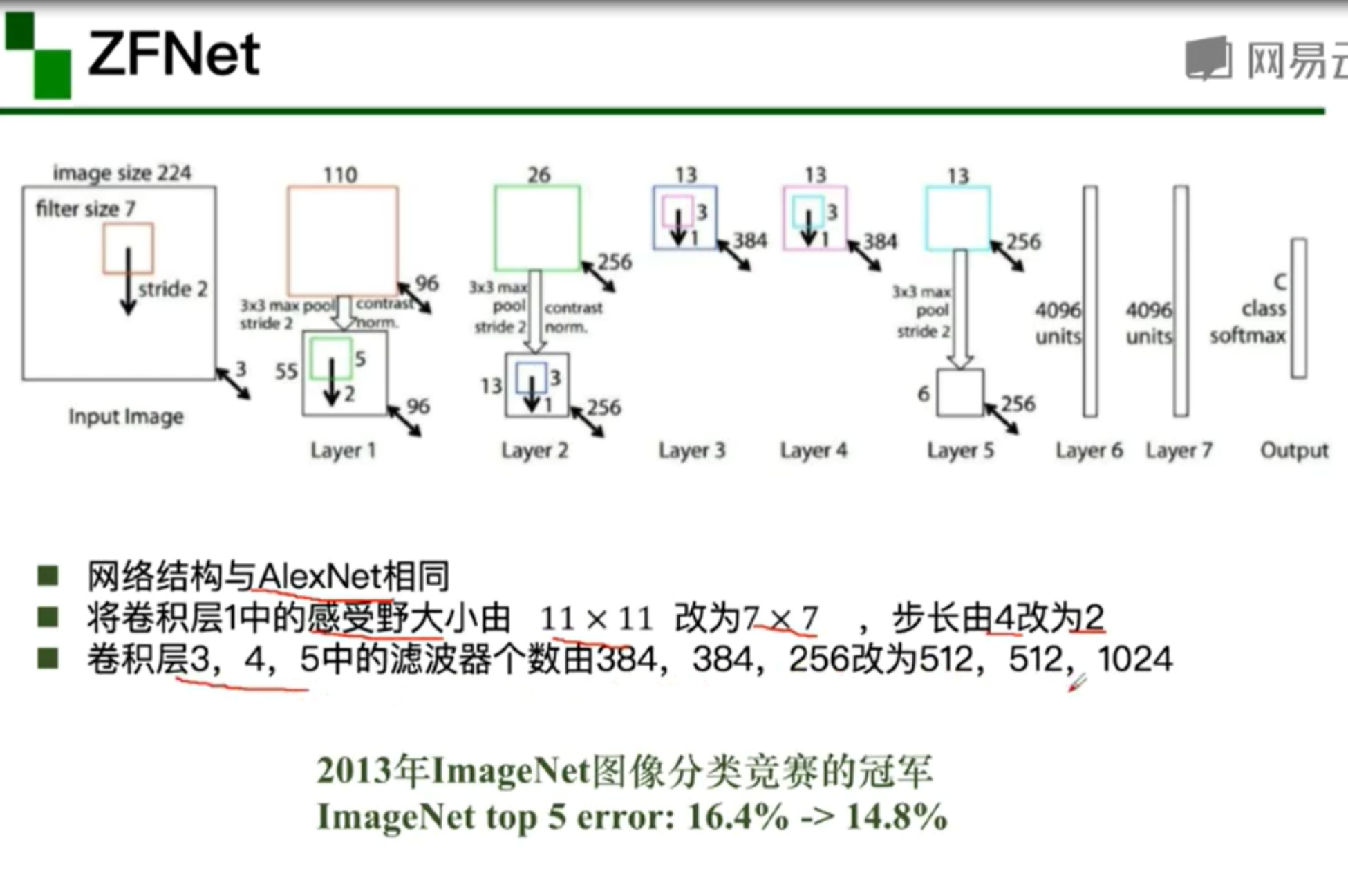

这个只是调整了一下参数。

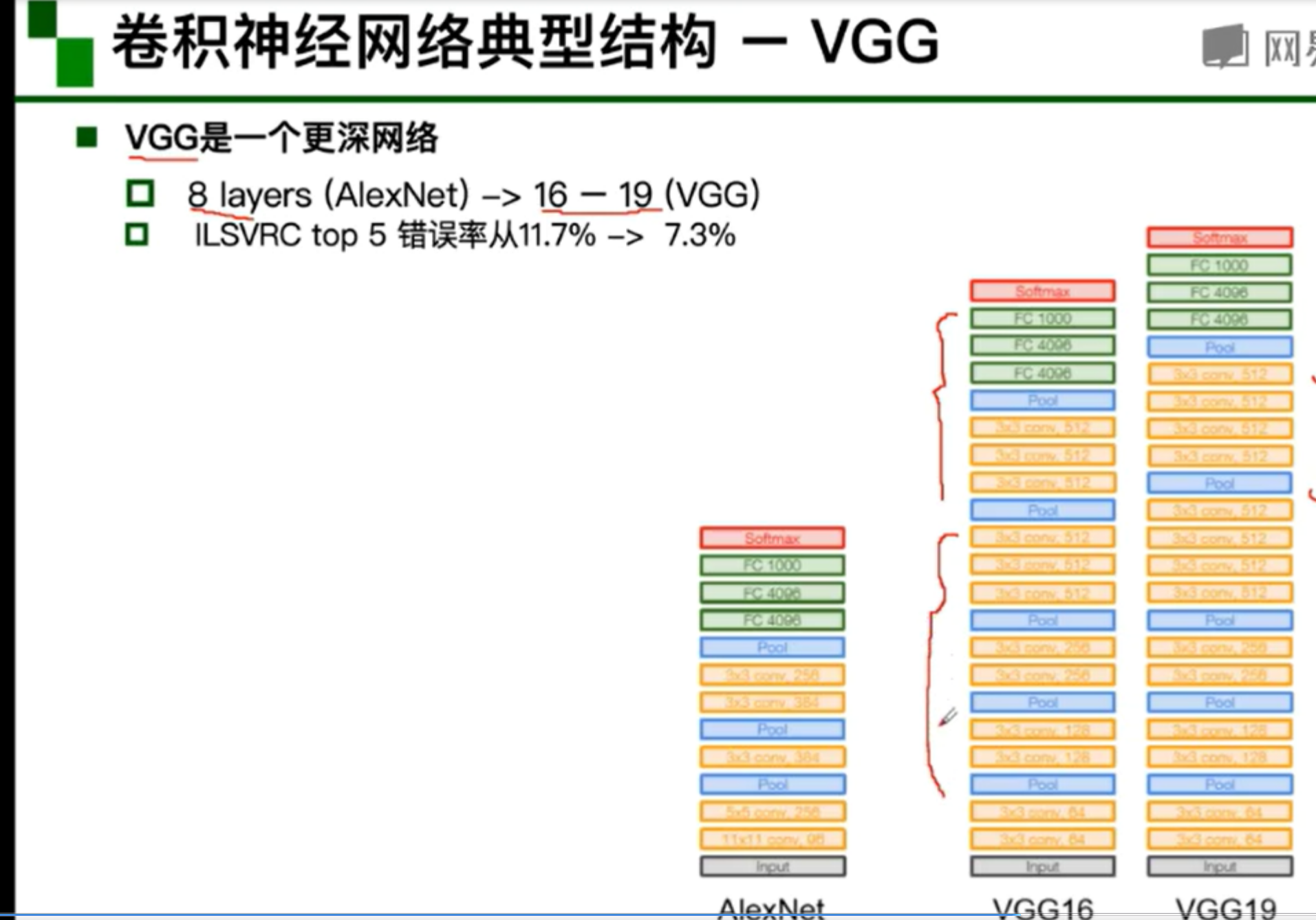

VGG 增加了一些层数,同时数据量也是ALEX的2倍左右,提出了迁移学习这一说法即利用别人现有的参数跑自己的任务。

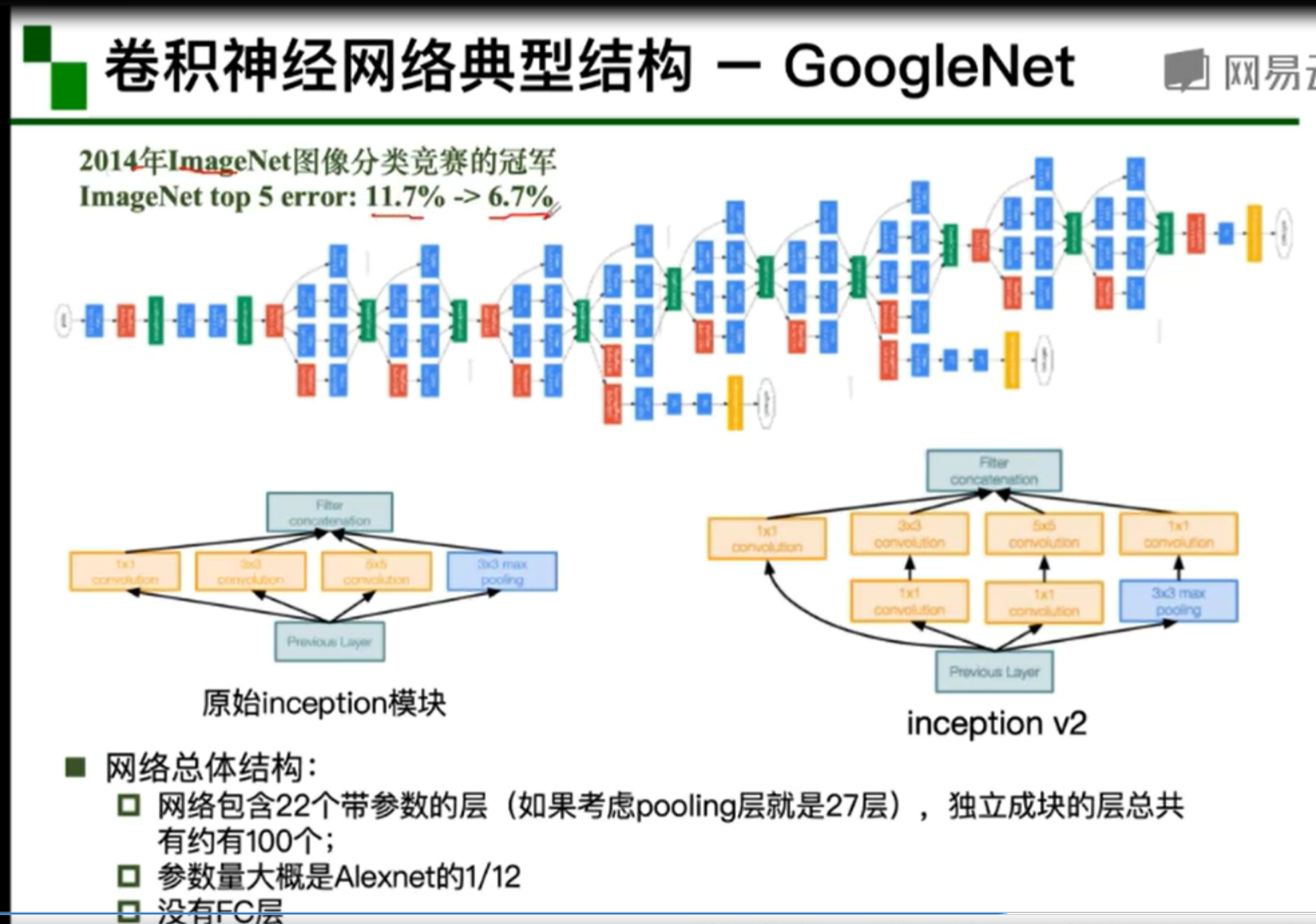

这个模型改变很大,且没有全连接,所以数据量小。

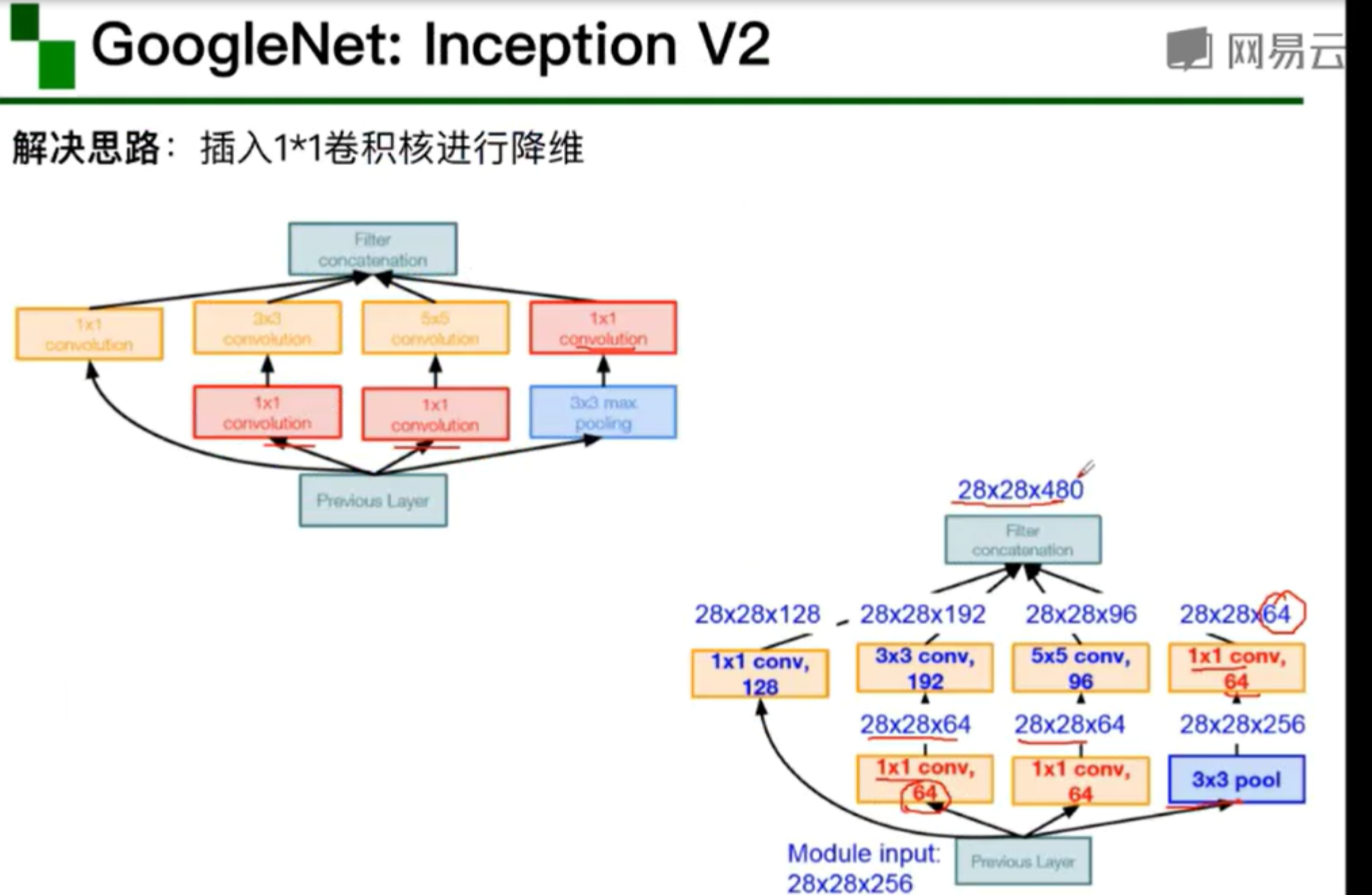

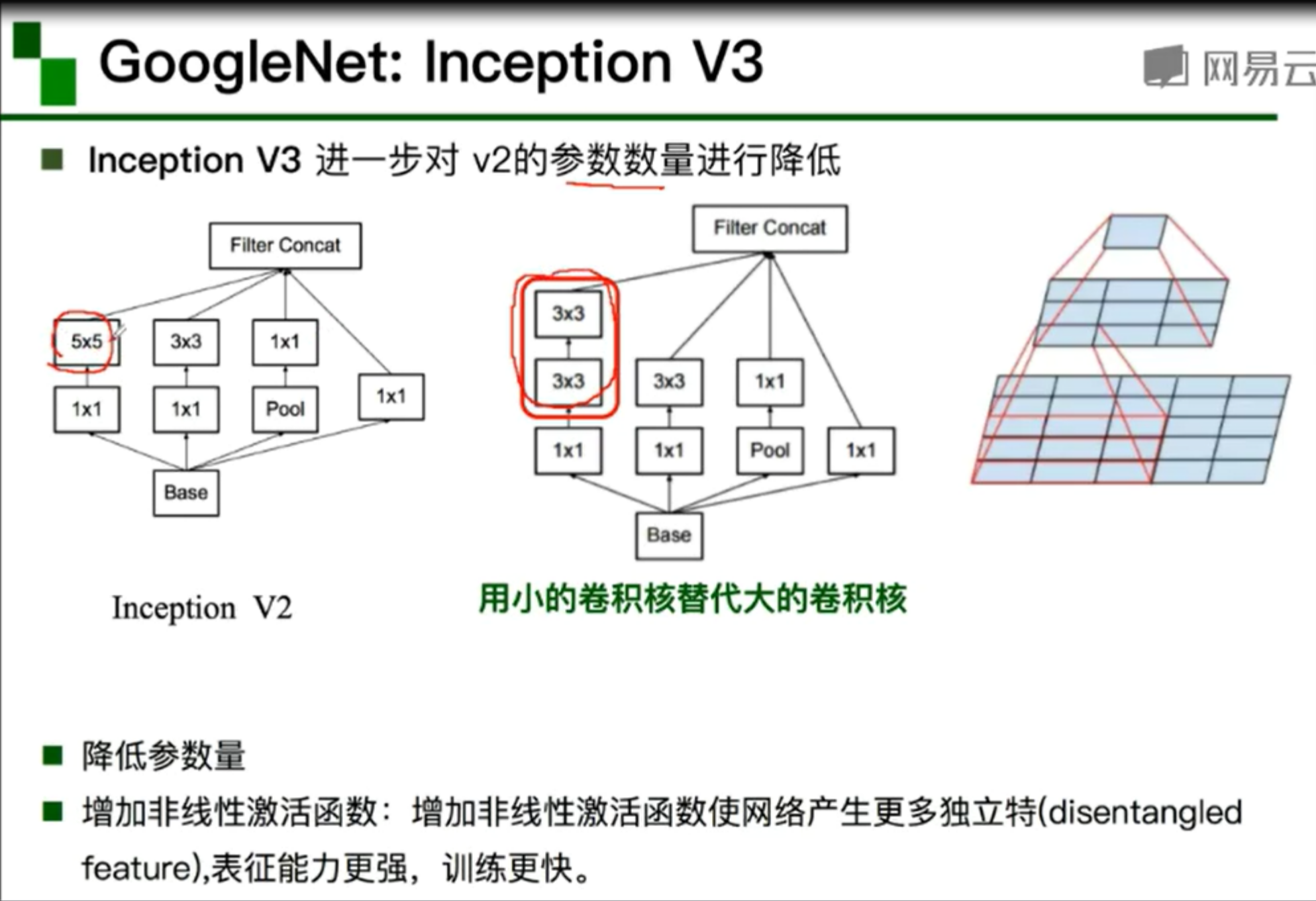

逐渐升级。用卷积核降低参数量,降低卷积核的大小。

带升级。时至今日也经常使用。

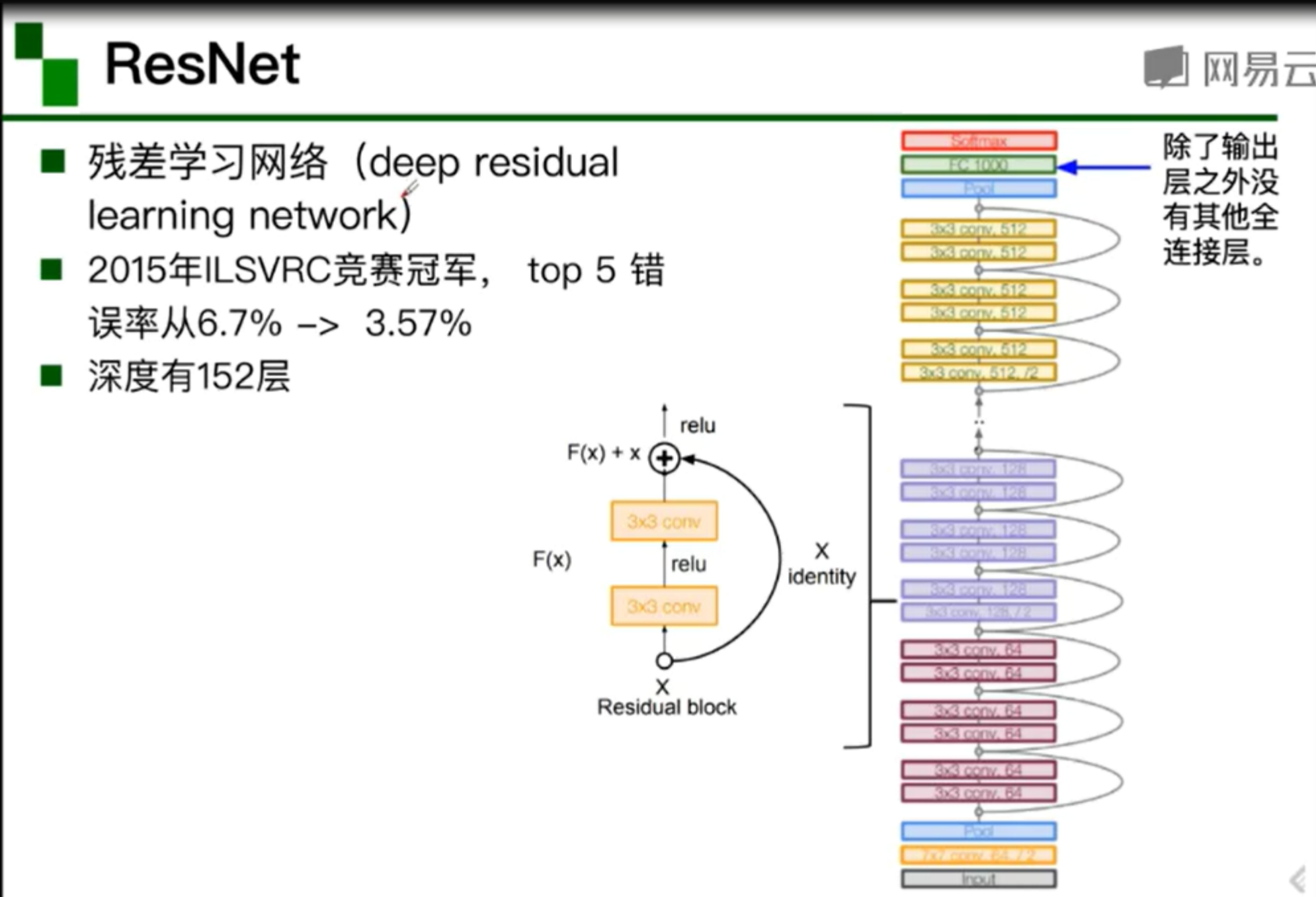

同样也是减少了FC

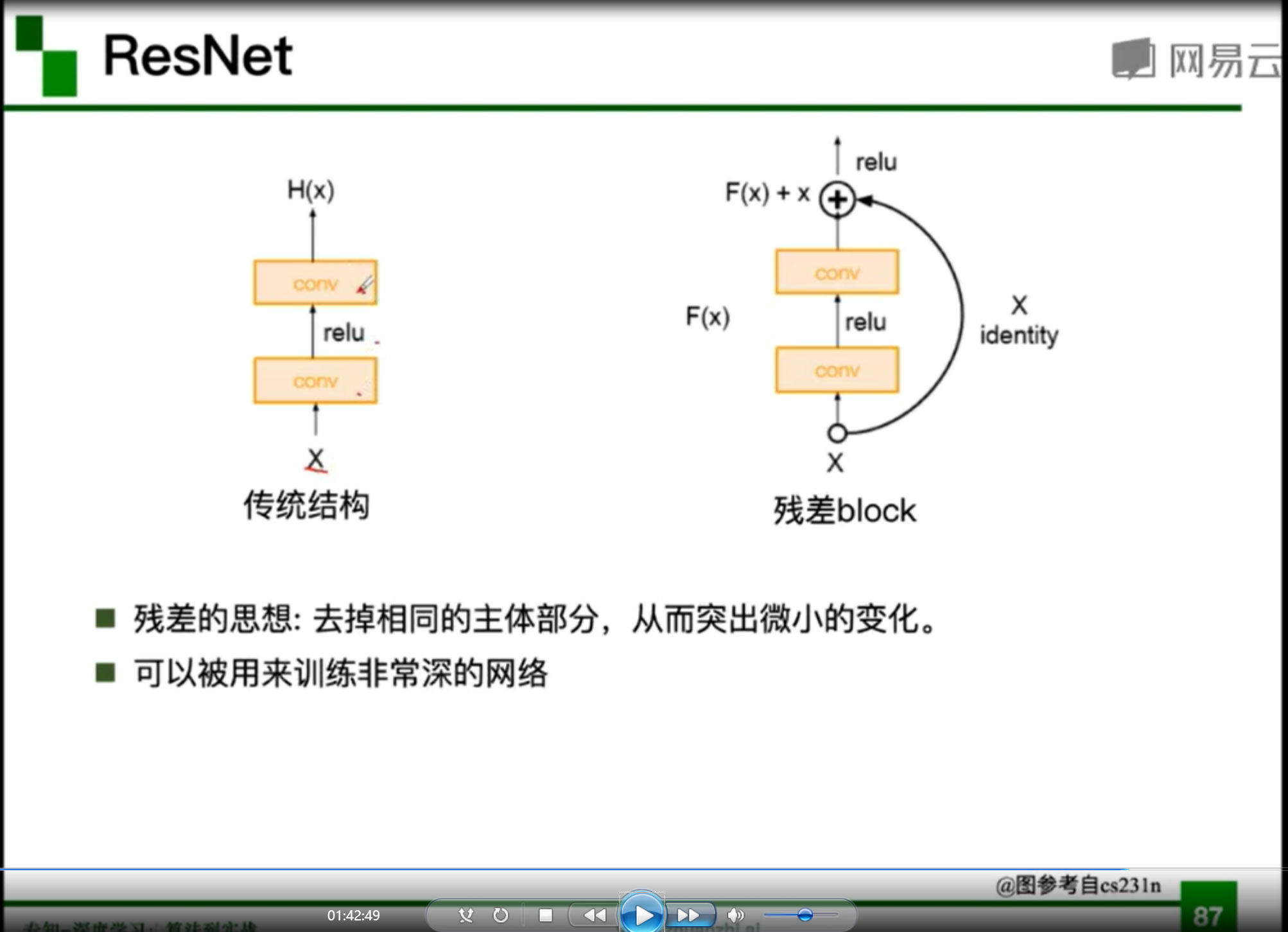

这里去除掉重复的主体部分,突出微小的变化(异或)

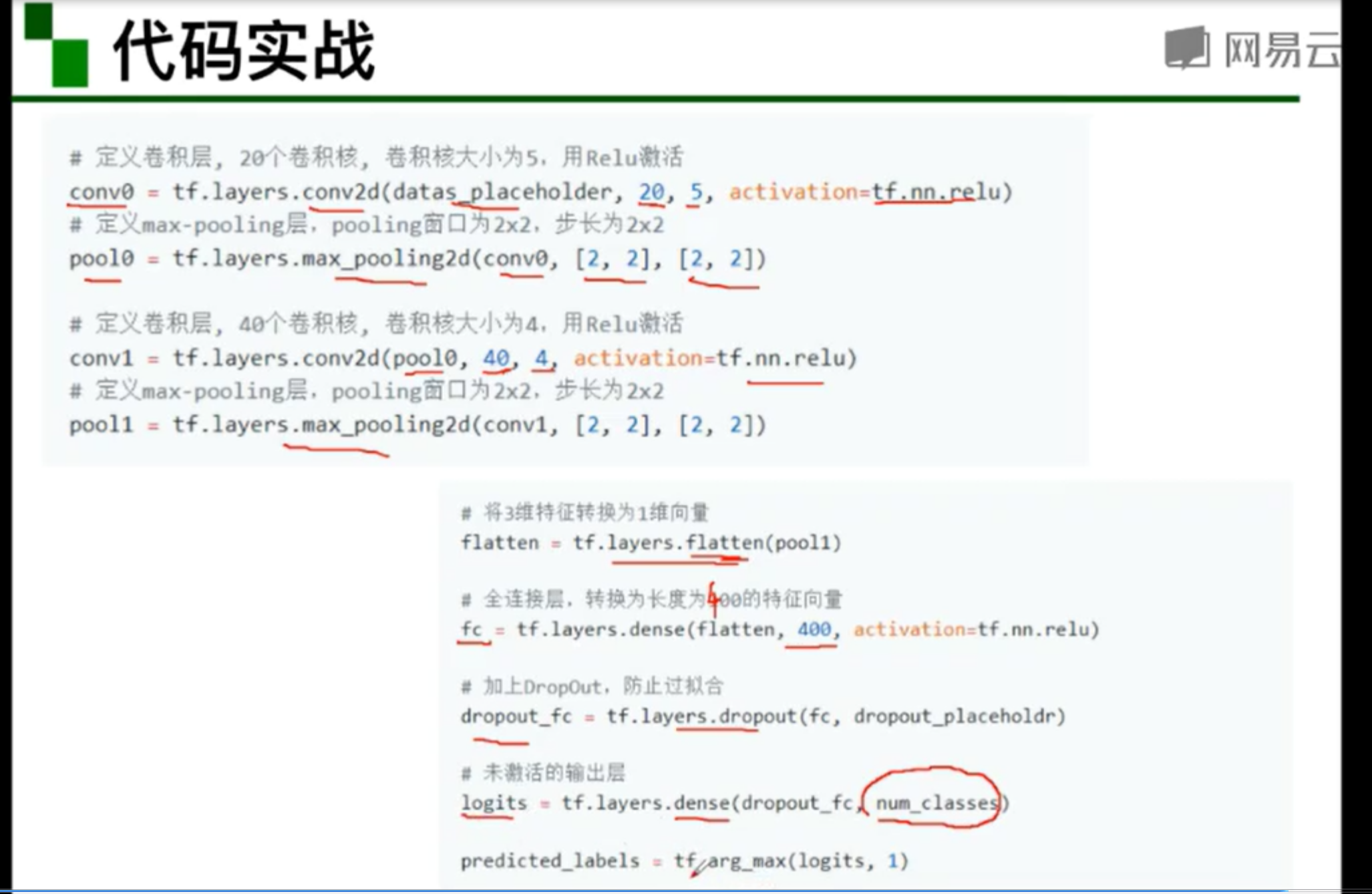

开始经典实战:

介绍了各种各样参数的意义。

part2

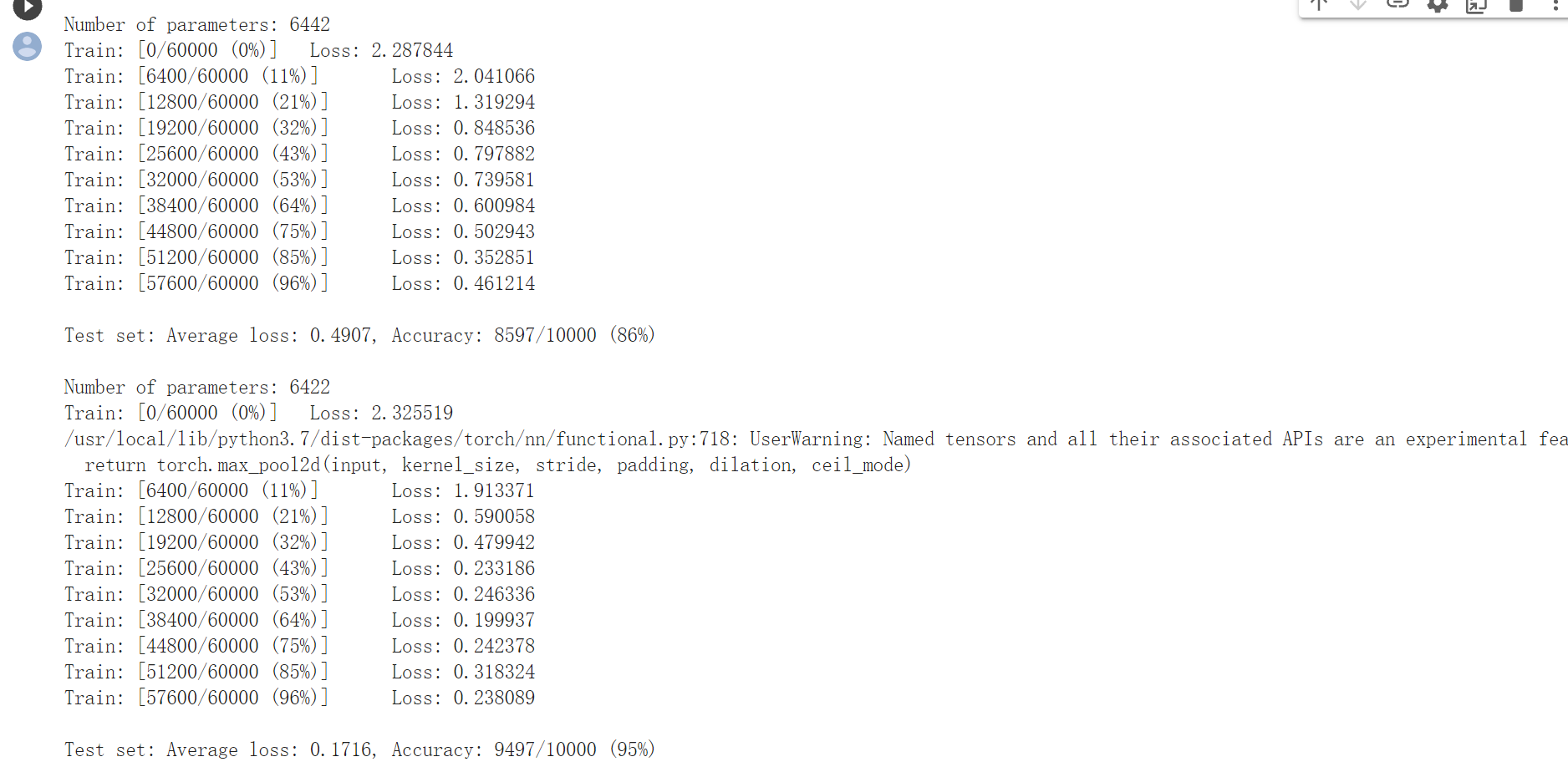

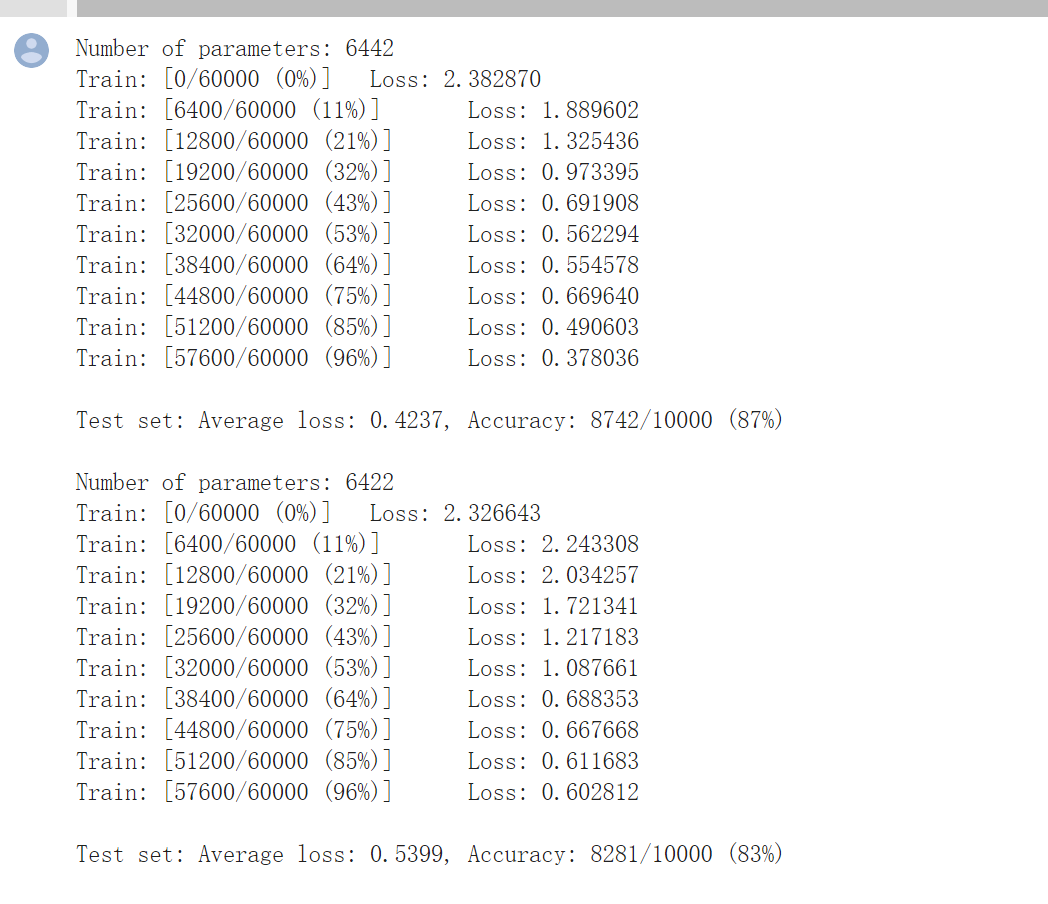

1.Convnet

在能利用局部联系时,卷积远超全连接。

但可惜,被打乱顺序后,没有局域联系,卷积的优势荡然无存。

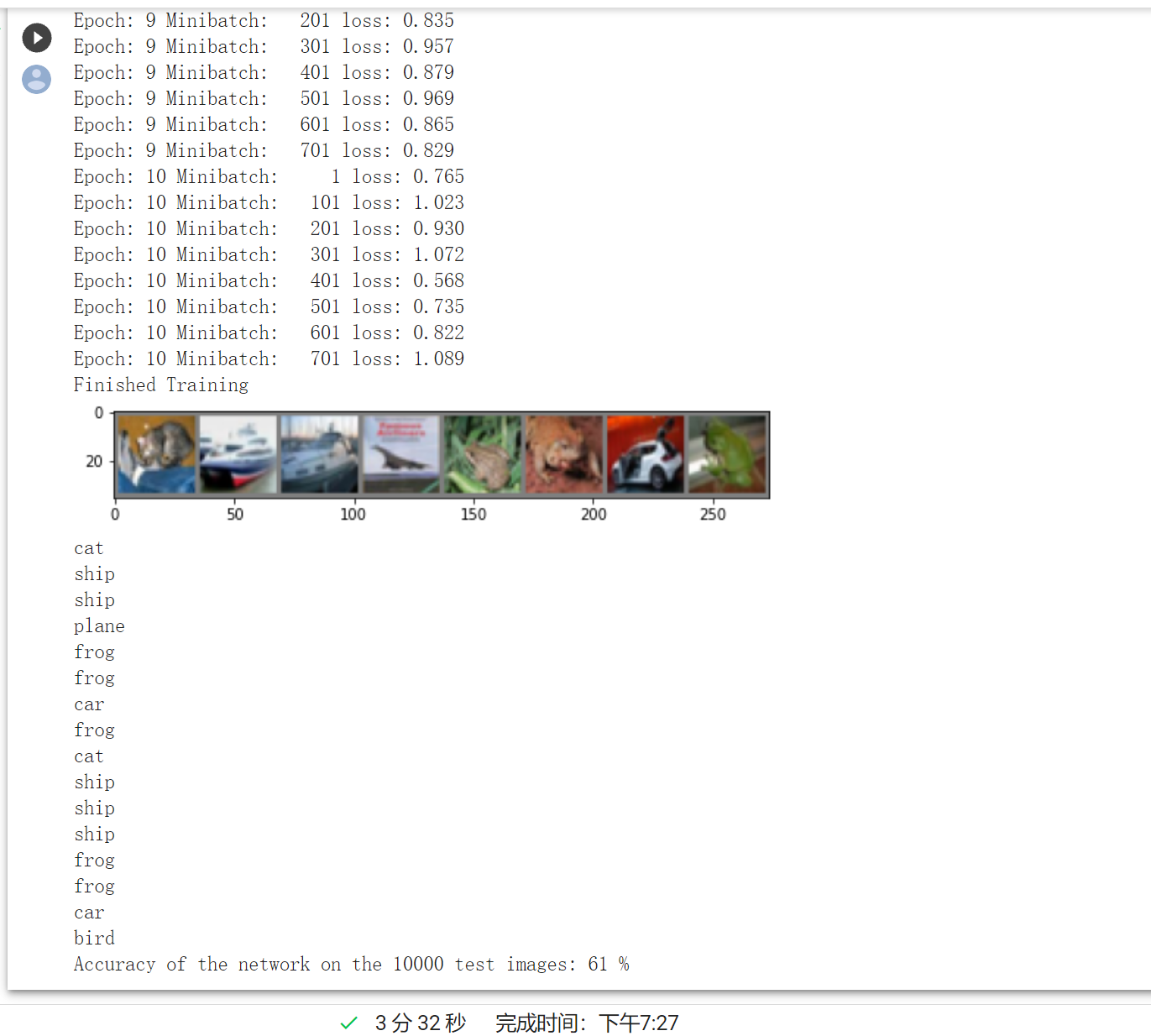

CNN处理下 准确率只有61。。

盲猜一手更换成ResNet准确率应该有不小的提升。。

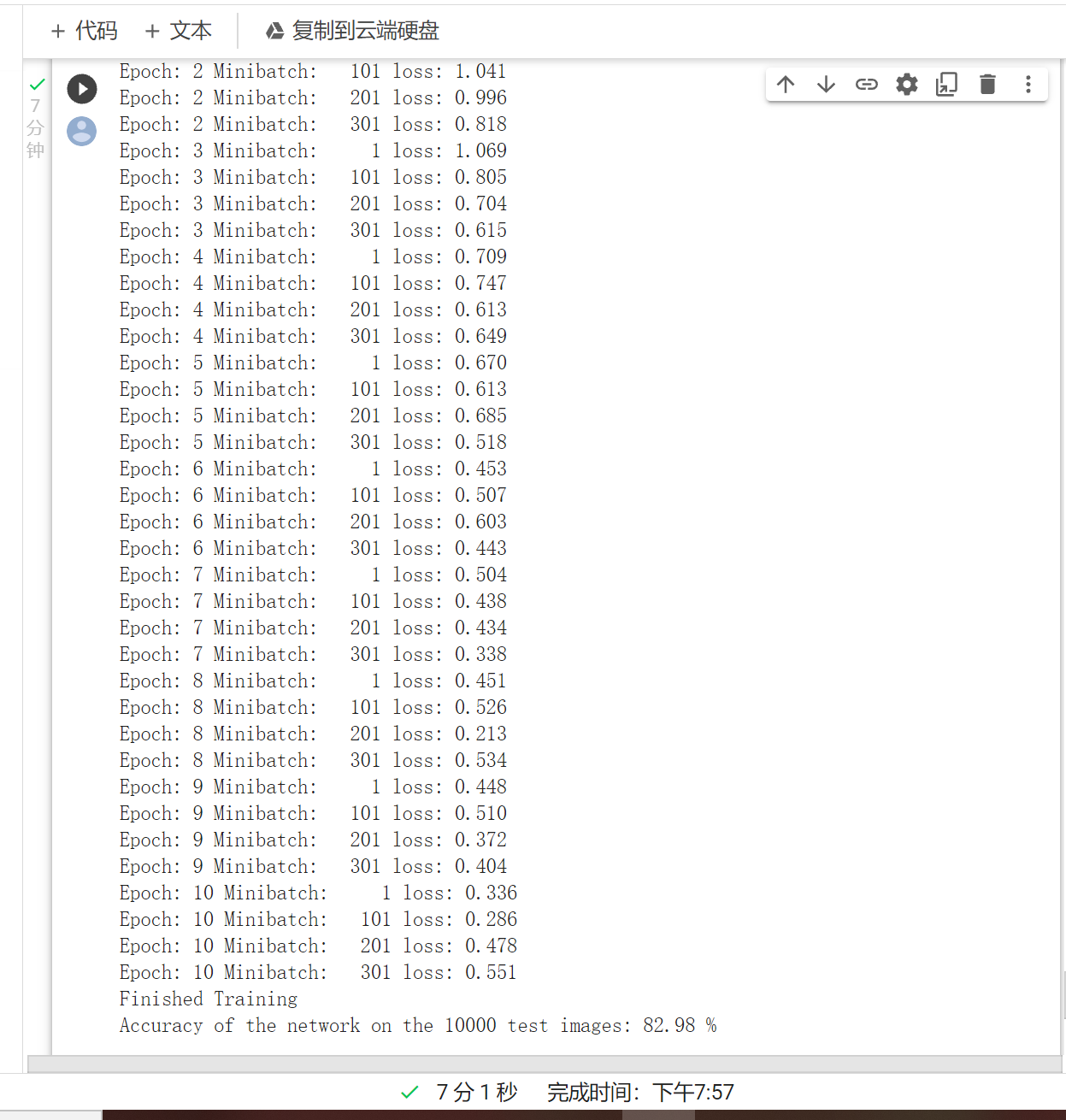

这里一开始没有用GPU训练,导致第一个就卡住了。

简单的VGG训练就可以达到83%,试想换成ResNet加上Attention机制不知道会如何。。

本期作业到这里 我们下周再见~