视频学习心得:

有图有真相

这个激活函数非常有意思 和ReLu函数相关性大。

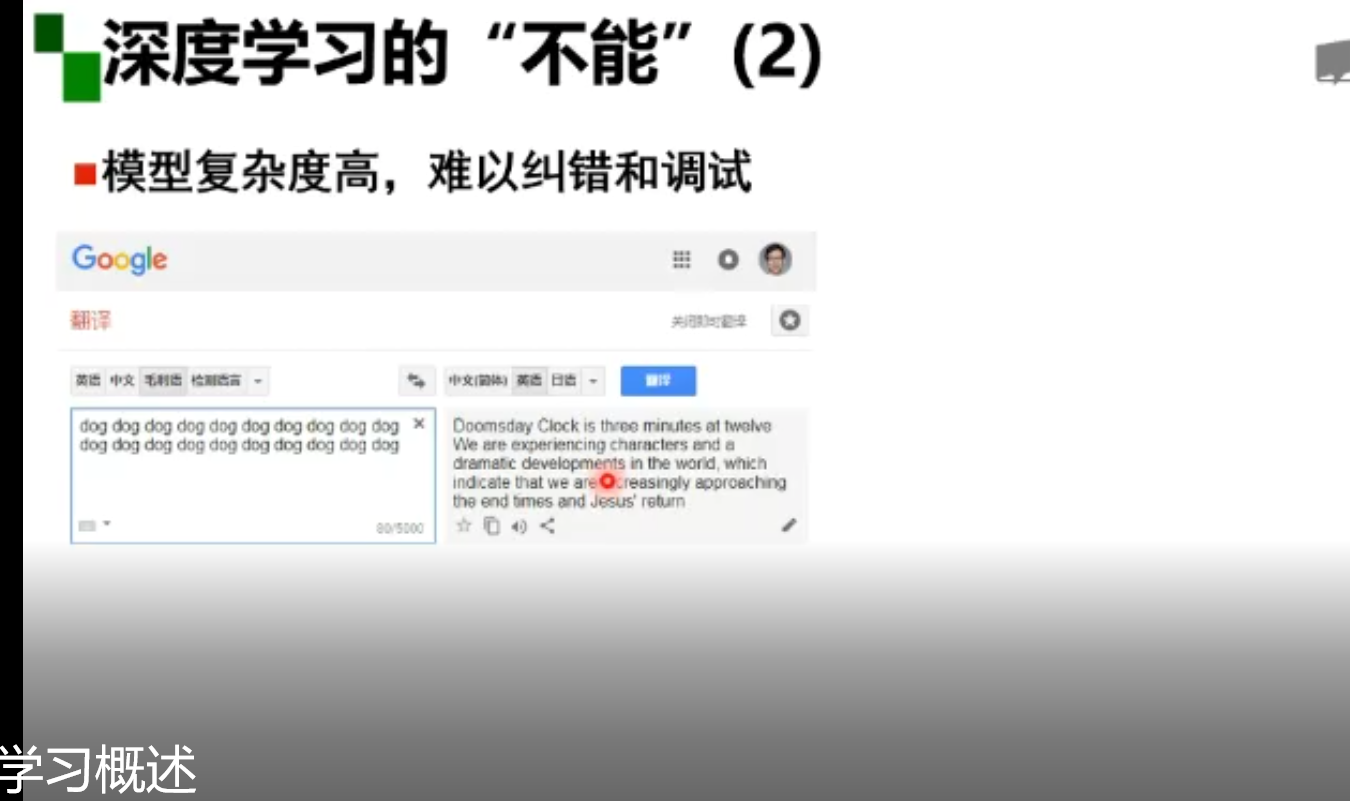

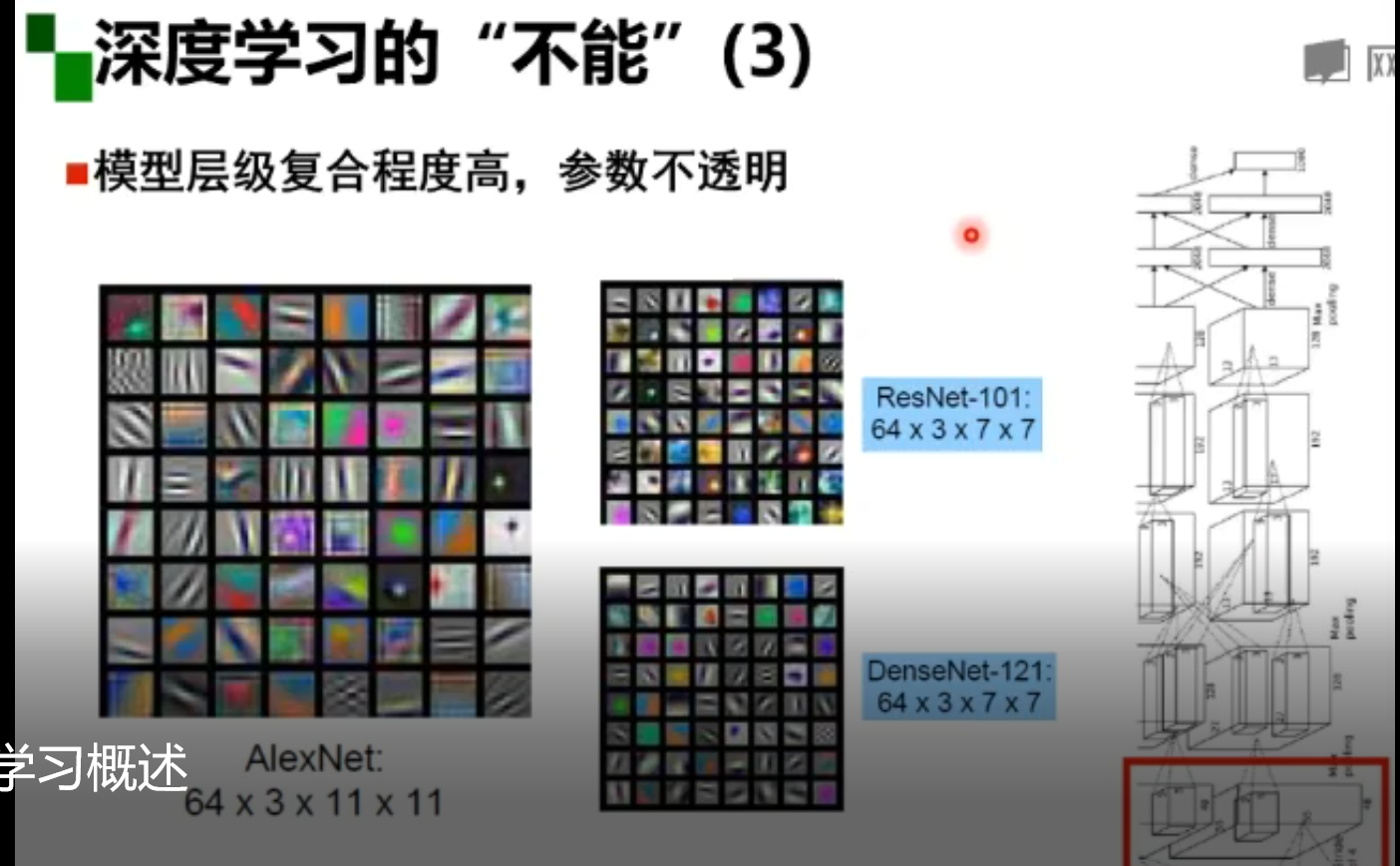

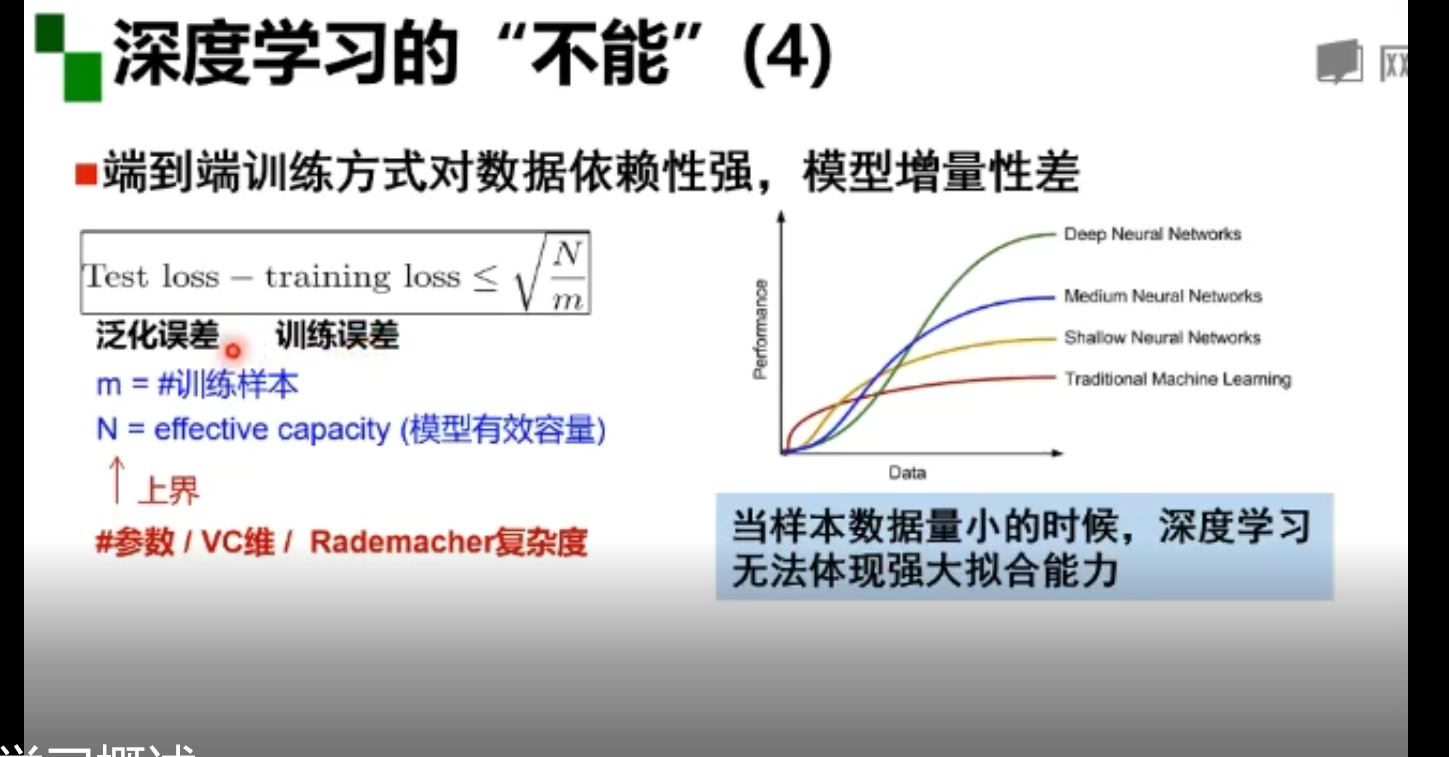

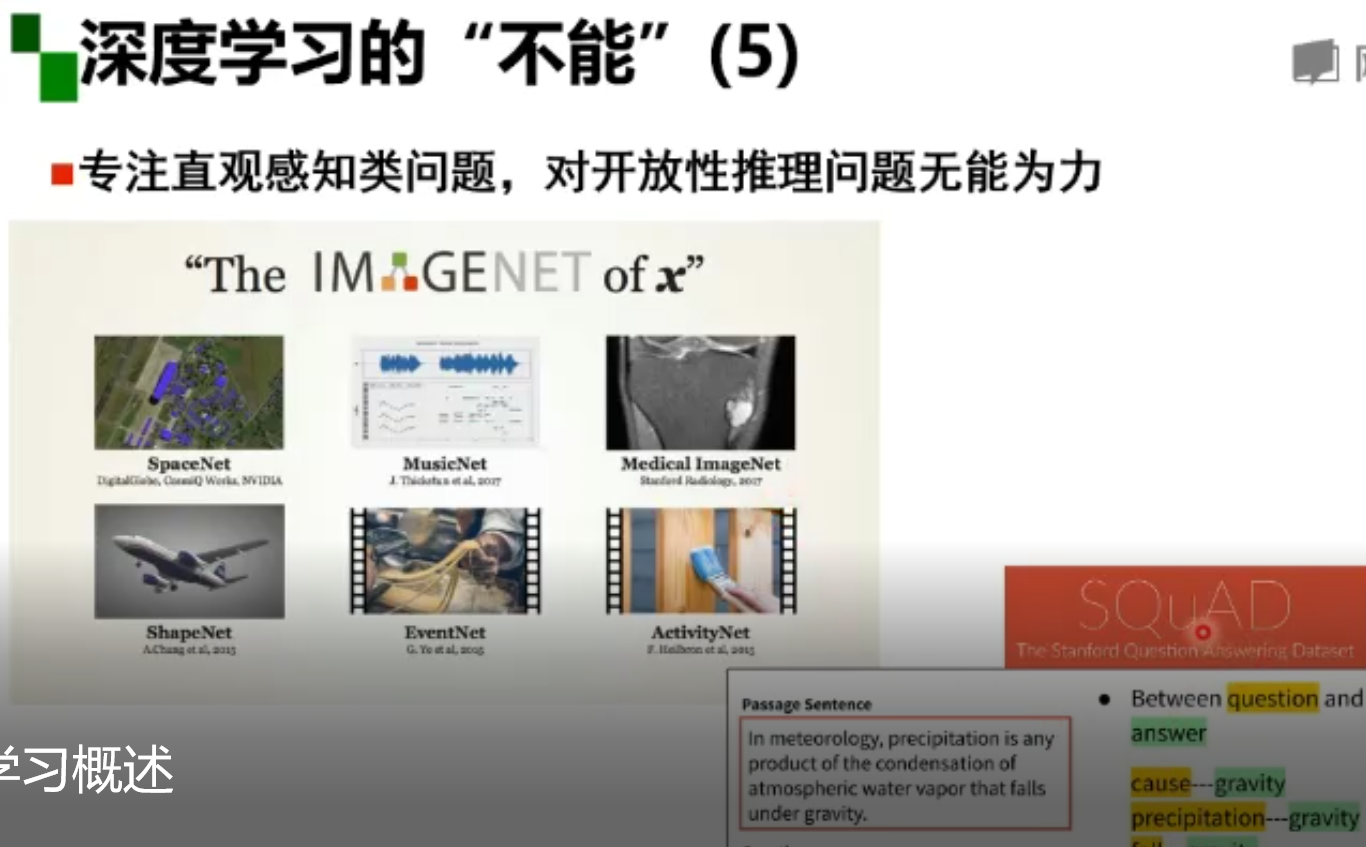

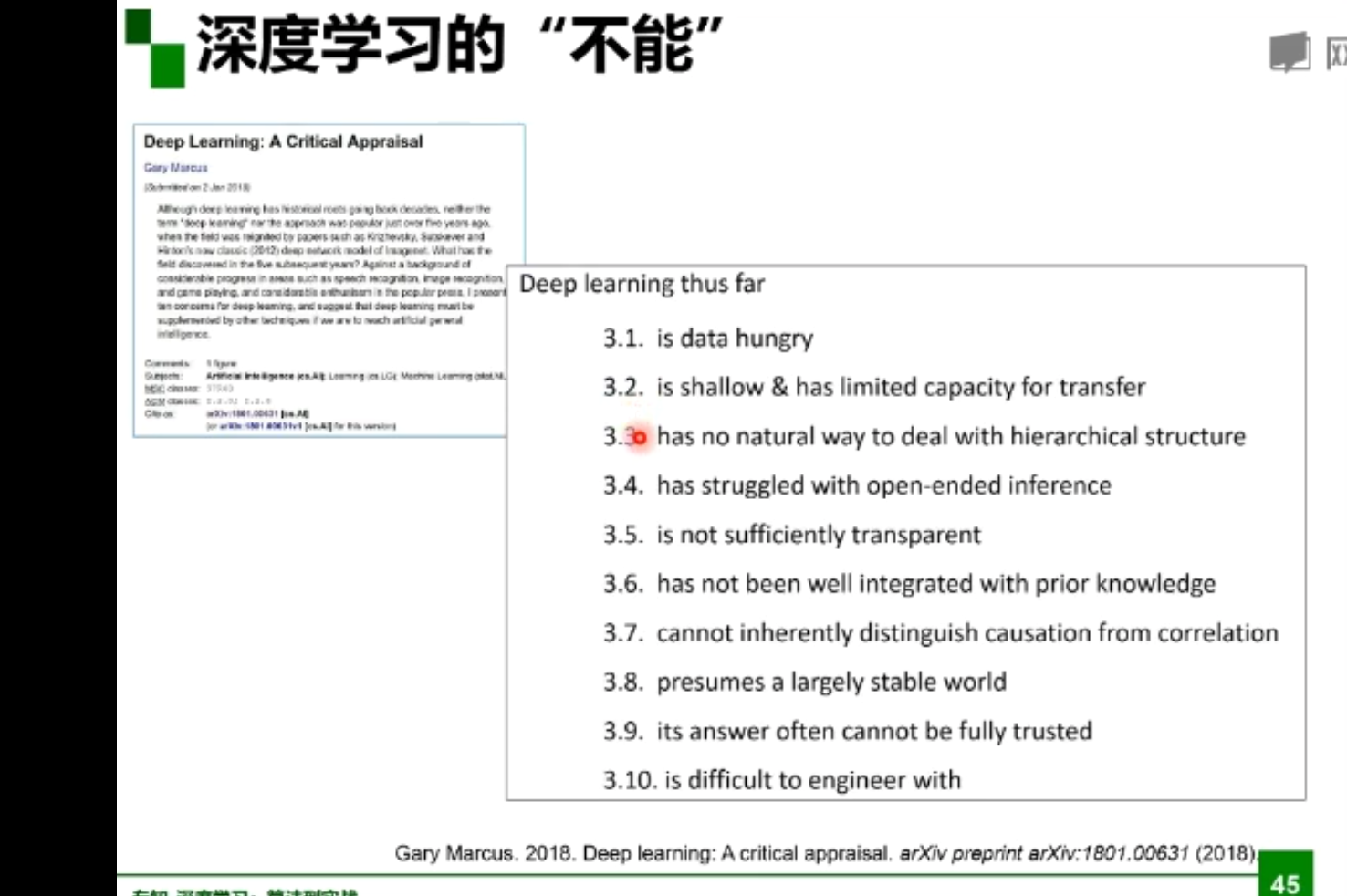

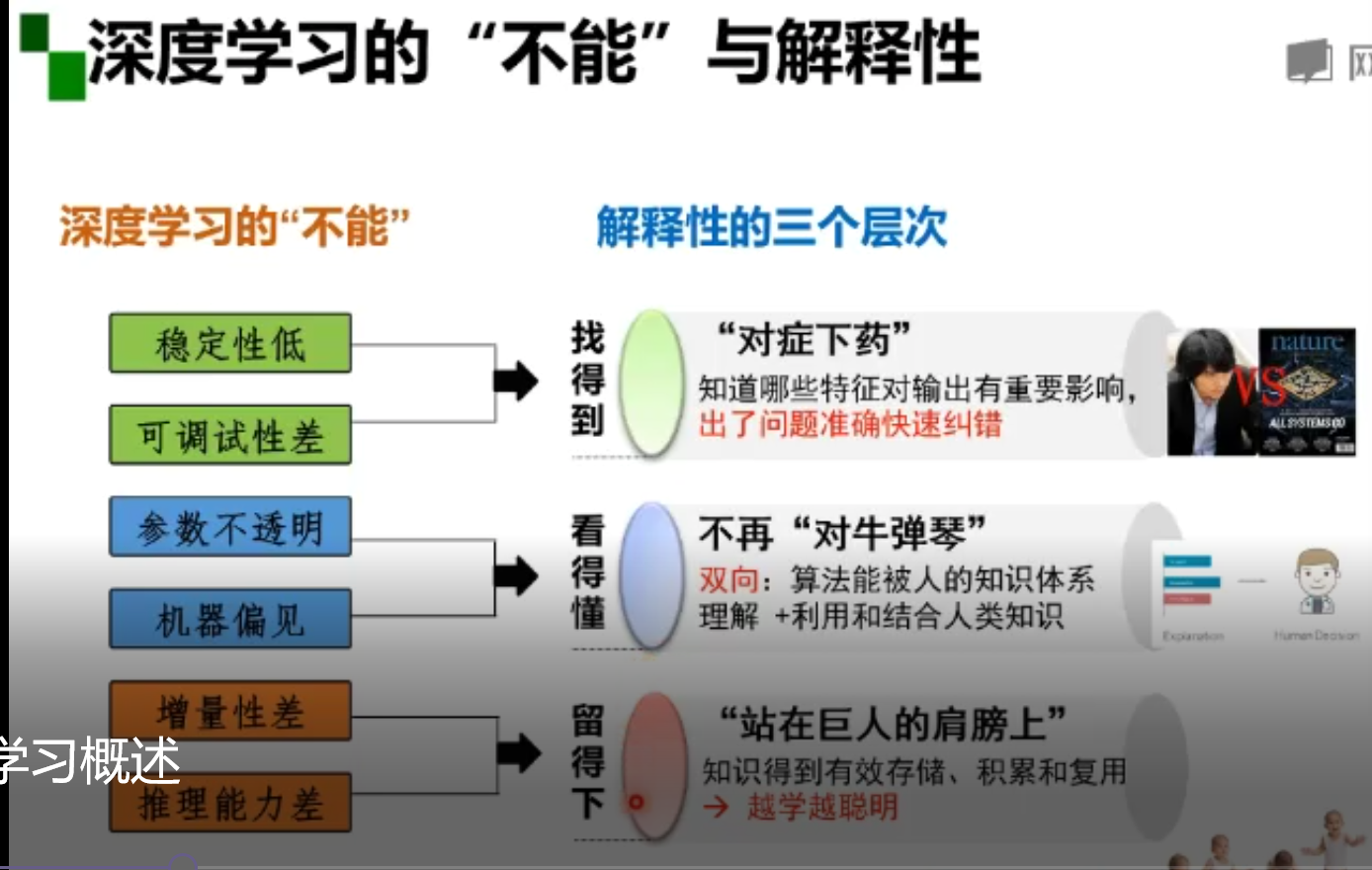

当然 深度学习也有‘不能’的地方

总结如下

1.深度学习依靠强大的算力。

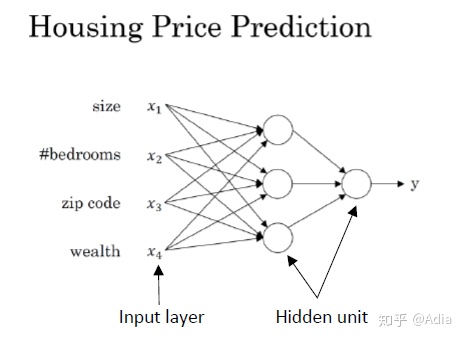

2.神经网络是一种强大的学习算法,它的灵感来自于大脑的工作方式。

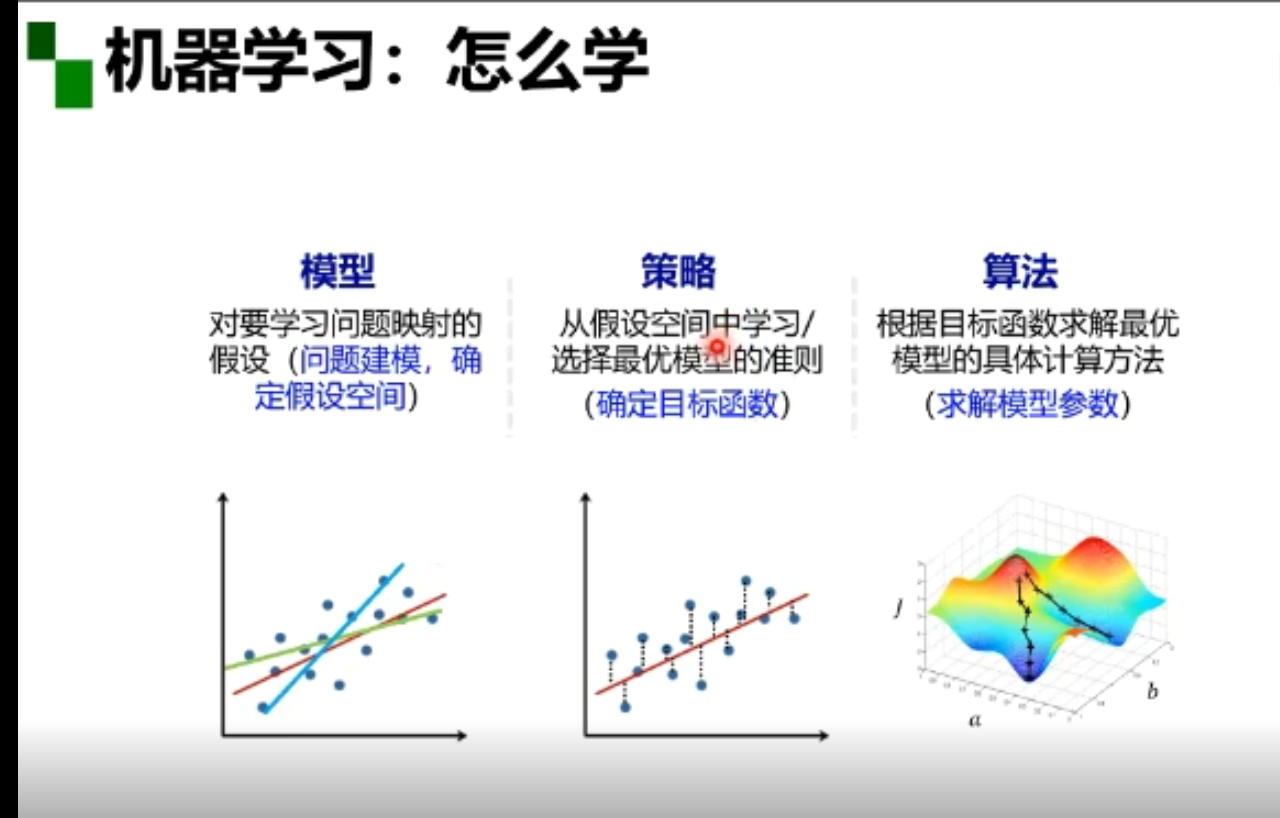

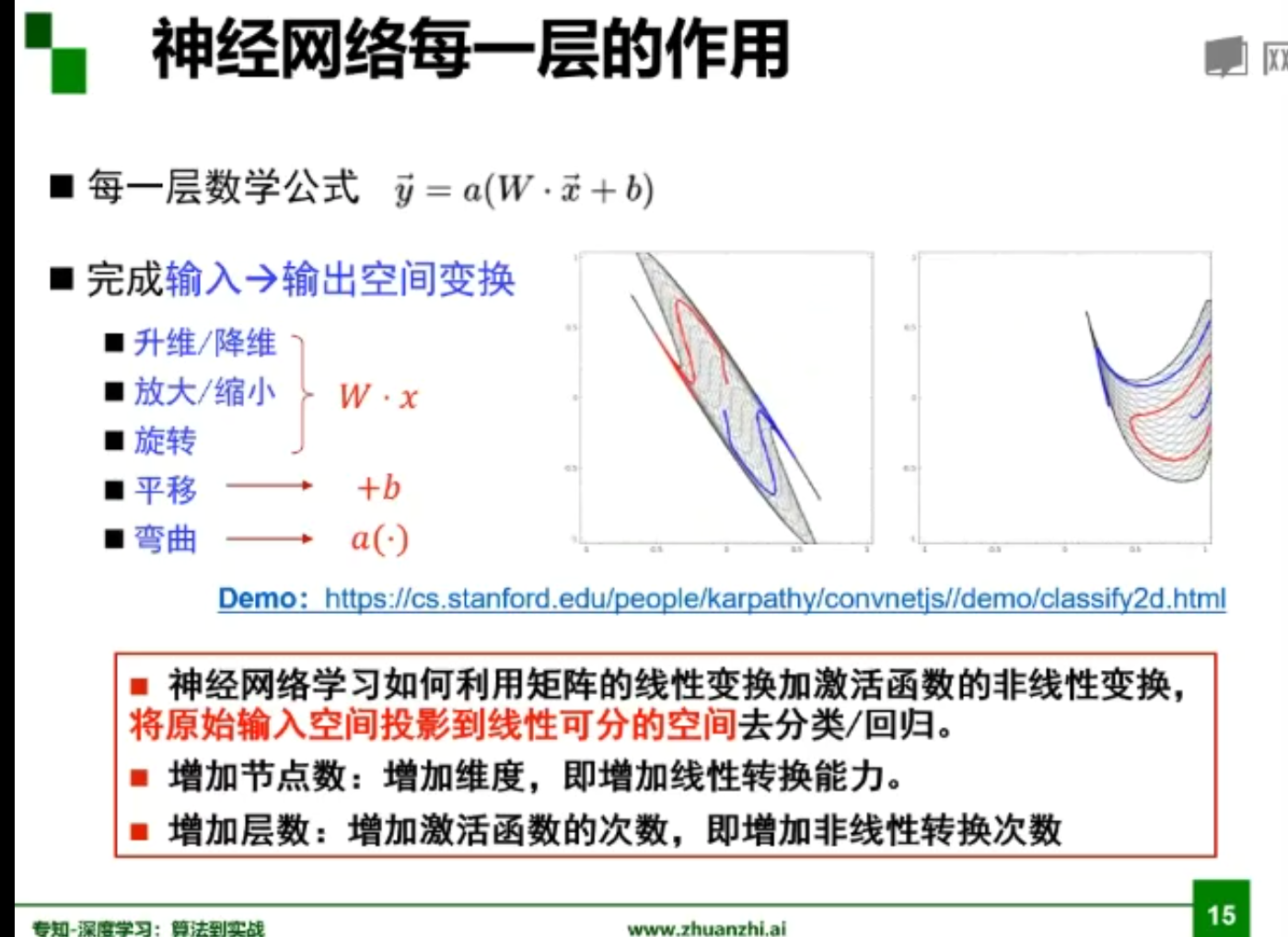

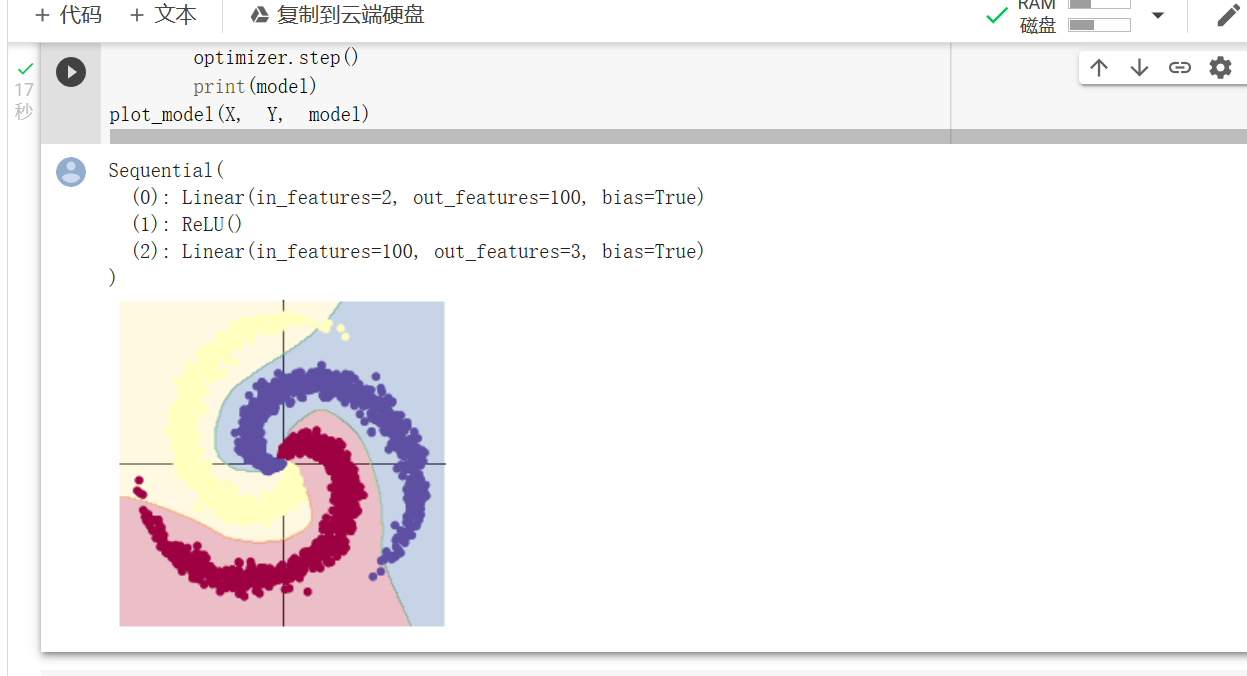

这是多元神经网络。本质上来说就是输入通过神经网络算法的映射从而尽量的靠近甚至命中最终的正确结果。

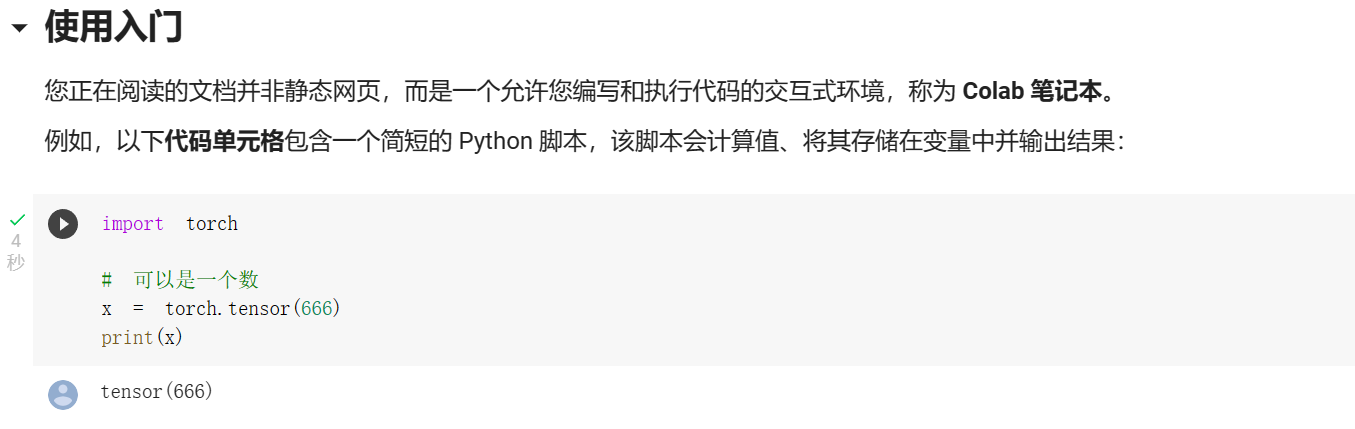

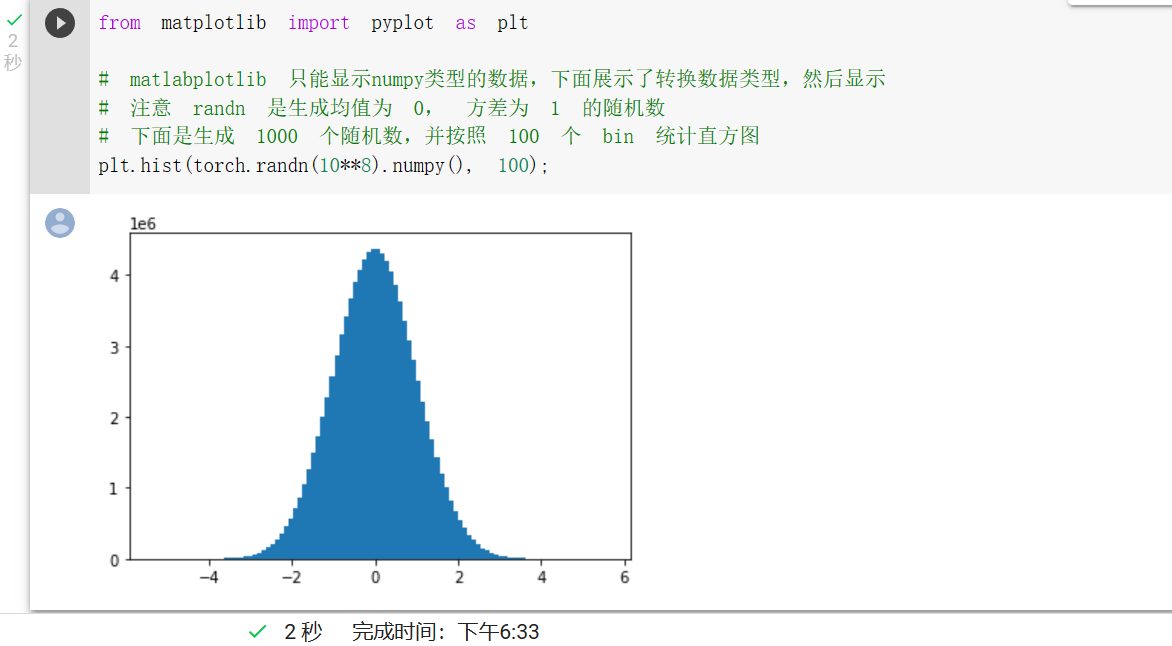

代码练习

part1

这部分主要通过复制粘贴对应的python代码并进行运行即可。

这个有个有意思的点 10**9会超时,错误原因是Overflow. 看来基础的东西还是不能丢啊。

老师皮了一下

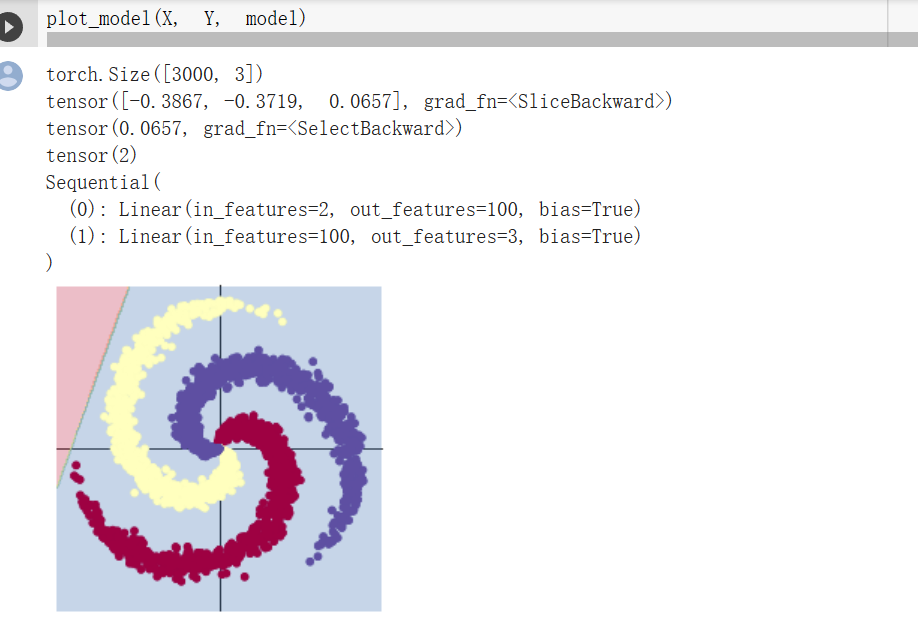

part2

这是线性模型分类 可以看出其准确率不高,对于这样的数据分布是难以进行准确分类的。

而这个是通过ReLU函数作为激活函数 分类的准确率确实得到了极大的提高。

小结

1.激活函数是用来加入非线性因素的,因为线性模型的表达力不够,比如上面两幅图的对比。

2.ReLU函数就是斜坡函数。

$$

f(x)=max(0,x),

$$

从表达式和可以明显地看出:ReLU其实就是个取最大值的函数。

ReLU函数其实是分段线性函数,把所有的负值都变为0,而正值不变,这种操作被成为单侧抑制。(也就是说:在输入是负值的情况下,它会输出0,那么神经元就不会被激活。这意味着同一时间只有部分神经元会被激活,从而使得网络很稀疏,进而对计算来说是非常有效率的。)正因为有了这单侧抑制,才使得神经网络中的神经元也具有了稀疏激活性。尤其体现在深度神经网络模型(如CNN)中,当模型增加N层之后,理论上ReLU神经元的激活率将降低2的N次方倍。

ReLU模型的优势如下:

1.没有饱和区,不存在梯度消失问题。

2.没有复杂的指数运算,计算简单、效率提高。

3.实际收敛速度较快,比 Sigmoid/tanh 快很多。

4.比 Sigmoid 更符合生物学神经激活机制。

参考博客:(https://blog.csdn.net/u013146742/article/details/51986575)

(https://www.cnblogs.com/tianqizhi/p/9570975.html)